Yüksek Bant Genişliği Belleğinin Gücünü Açığa Çıkarmak: HBM Arayüz Tasarımı 2025 ve Sonrasında AI Hızlandırıcılarında Devrim Yaratıyor. AI Donanımının Gelecek Dönemini Şekillendiren Teknolojiler, Pazar Büyümesi ve Stratejik Fırsatları Keşfedin.

- Yönetici Özeti: Temel Bulgular ve Stratejik İçgörüler

- Pazar Genel Görünümü: 2025 Yılında AI Hızlandırıcıları için HBM Arayüz Tasarımı

- Teknoloji Manzarası: HBM Standartları ve Mimarilerinin Evrimi

- Rekabet Analizi: Önde Gelen Oyuncular ve İnovasyon Trendleri

- Pazar Büyüklüğü ve Tahmin (2025–2030): CAGR, Gelir Tahminleri ve Bölgesel Dağılım

- Sürücüler ve Zorluklar: Performans Talepleri, Güç Verimliliği ve Entegrasyon Karmaşıklıkları

- Yeni Uygulamalar: AI, HPC, Veri Merkezleri ve Kenar Hesaplama

- Tedarik Zinciri ve Ekosistem Analizi

- Gelecek Beklentisi: Yıkıcı Teknolojiler ve Gelecek Nesil HBM Arayüzleri

- Paydaşlar için Stratejik Öneriler

- Kaynaklar & Referanslar

Yönetici Özeti: Temel Bulgular ve Stratejik İçgörüler

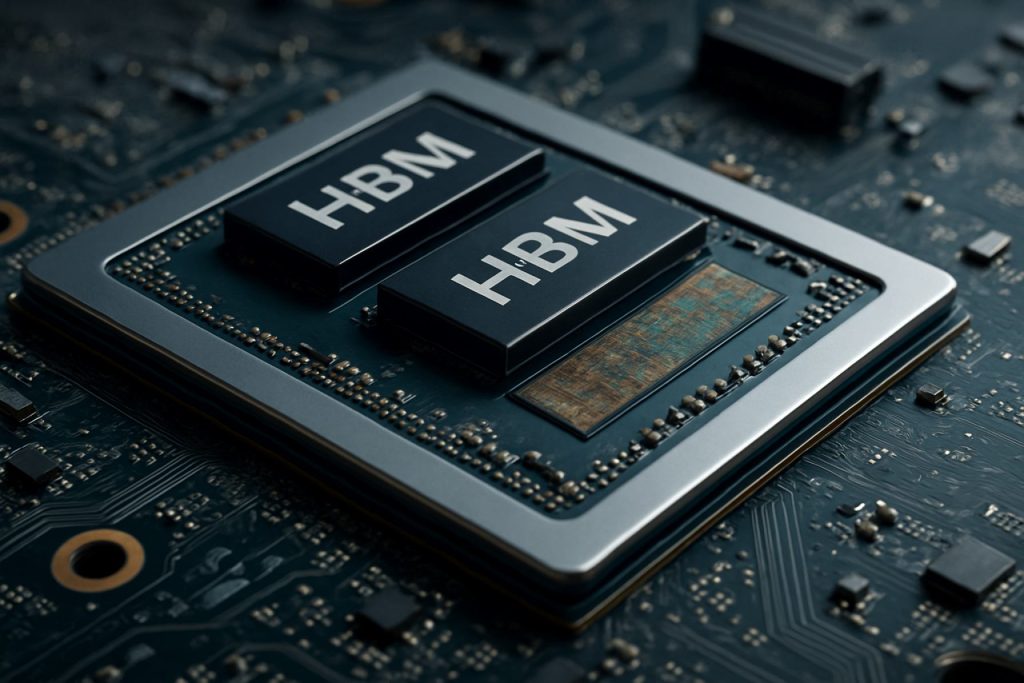

Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımı, gelecek nesil AI hızlandırıcıları için kritik bir etken olarak ortaya çıkmıştır ve veri yoğun uygulamalarda bellek bant genişliği, enerji verimliliği ve kompakt form faktörleri için yükselen talepleri karşılamaktadır. 2025’te, özellikle derin öğrenme ve büyük dil modelleri açısından AI iş yüklerinin hızlı evrimi, saniyede terabaytlarca bant genişliği sunabilen bellek çözümlerine olan ihtiyacı artırmaktadır ve bu süreçte gecikmeyi ve güç tüketimini en aza indirmek önem kazanmaktadır. HBM, 3D yığınlanmış mimarisi ve silikon içinden geçiş (TSV) teknolojisi ile önde gelen AI hızlandırıcı sağlayıcıları için tercih edilen bellek arayüzü haline gelmiştir.

Anahtar bulgular, HBM3’ün benimsenmesinin ve beklenen HBM4’ün piyasaya sürülmesinin bant genişliği açısından yeni kriterler belirlediğini ortaya koymaktadır; HBM3, yığın başına 819 GB/s’ye kadar sunarken, HBM4’ün 1 TB/s’yi aşması beklenmektedir. Bu gelişmeler, AI hızlandırıcılarının büyük veri setlerini gerçek zamanlı olarak işleme yeteneğini artırarak eğitim ve çıkarım verimliliğini önemli ölçüde iyileştirmektedir. Samsung Electronics Co., Ltd., Micron Technology, Inc., ve SK hynix Inc. gibi büyük endüstri oyuncuları, arayüz protokollerini ve sinyal bütünlüğünü optimize etmek için AI donanım tasarımcılarıyla yakın işbirliği yapmaktadır.

Stratejik içgörüler, başarılı bir HBM arayüz tasarımının birkaç faktöre bağlı olduğunu göstermektedir: ileri paketleme teknikleri (örneğin, 2.5D ve 3D entegrasyon), sağlam termal yönetim ve bellek denetleyicilerinin AI işlemci çekirdekleriyle birlikte tasarlanması. Advanced Micro Devices, Inc. ve NVIDIA Corporation gibi firmalar, bu stratejileri kullanarak olağanüstü performans-güç metriklerine sahip AI hızlandırıcıları sunmaktadır. Ayrıca, HBM’nin çiplet tabanlı mimarilerle entegrasyonu, modülerlik ve ölçeklenebilirlik sunarak gelecekteki AI sistemleri için önem kazanmaktadır.

Geleceğe bakıldığında, HBM arayüz ekosisteminin, yeni bellek çözümleri için birlikte çalışabilirliği kolaylaştırarak ve pazara çıkış sürelerini hızlandırarak JEDEC Solid State Technology Association gibi kuruluşların liderliğindeki standartlaştırma çabalarından faydalanması beklenmektedir. AI modellerinin karmaşıklığının artmaya devam etmesiyle birlikte, HBM arayüz tasarımının, gelişen AI iş yükleri ile stratejik uyumu, AI donanım alanında rekabet avantajını sürdürmek için şart olacaktır.

Pazar Genel Görünümü: 2025 Yılında AI Hızlandırıcıları için HBM Arayüz Tasarımı

AI hızlandırıcılarındaki Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımı pazarı, yapay zeka ve makine öğrenimi iş yüklerinin yükselen hesaplama talepleriyle 2025’te önemli bir büyüme kaydetmeye hazırlanıyor. HBM, 3D yığınlanmış DRAM teknolojisi olarak, geleneksel bellek çözümlerine kıyasla bellek bant genişliği ve enerji verimliliğinde önemli iyileştirmeler sunmaktadır, bu nedenle gelecek nesil AI hızlandırıcıları için kritik bir etken haline gelmiştir.

2025 yılında, HBM arayüzlerinin benimsenmesi, AI eğitim ve çıkarım görevlerindeki bellek darboğazlarını aşmak isteyen önde gelen yarı iletken şirketleri ve hiperskal veri merkezi operatörleri tarafından hızlandırılmaktadır. HBM3 ve yeni gelişen HBM3E gibi en son HBM standartları, 1 TB/s’yi aşan bant genişlikleri sunmakta ve büyük dil modellerinin ve üretken AI sistemlerinin paralel işleme gereksinimlerini desteklemektedir. Samsung Electronics Co., Ltd., Micron Technology, Inc., ve SK hynix Inc. gibi şirketler, AI hızlandırıcı tasarımlarına hızla entegre edilen bellek çözümleri sağlayarak HBM gelişiminde öncü konumdadır.

AI hızlandırıcılarındaki HBM için arayüz tasarımı giderek daha karmaşık hale gelmektedir; bu, 2.5D ve 3D entegrasyon gibi ileri paketleme teknolojileri gerektirmektedir. Bu yaklaşımlar, HBM yığınlarının işlem birimlerine yakın fiziksel konumlandırılmasını sağlayarak, gecikmeyi en aza indirmekte ve veri aktarımını maksimize etmektedir. Tayvan Yarı İletken Üretim Şirketi (TSMC) ve Intel Corporation gibi yarı iletken dökümhaneleri, bu mimarileri desteklemek için gelişmiş yerleştirme ve paketleme çözümlerine yatırım yapmaktadır.

HBM destekli AI hızlandırıcılarına olan talep, özellikle bulut veri merkezlerinde, kenar hesaplama ve yüksek performanslı hesaplama (HPC) sektörlerinde oldukça yüksektir. NVIDIA Corporation ve Advanced Micro Devices, Inc. (AMD) gibi büyük AI çip tedarikçileri, gelişmiş AI modelleri için gerekli bellek bant genişliğini sunabilmek için HBM’yi amiral gemisi ürünlerine entegre etmektedir. Rekabet ortamı, aynı zamanda JEDEC Solid State Technology Association gibi kuruluşlardan gelen gelişen standartlarla şekillenmekte, bu kuruluşlar gelecek AI gereksinimlerini karşılamak için yeni HBM spesifikasyonlarını tanımlamaya devam etmektedir.

Genel olarak, 2025 yılında AI hızlandırıcıları için HBM arayüz tasarım pazarı, hızlı yenilikçilik, yarı iletken tedarik zinciri boyunca stratejik ortaklıklar ve bellek bant genişliği, enerji verimliliği ve ölçeklenebilirliğe sürekli odaklanma ile karakterize edilmektedir.

Teknoloji Manzarası: HBM Standartları ve Mimarilerinin Evrimi

Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımı için teknoloji manzarası, AI hızlandırıcılarının artan taleplerini karşılamak üzere hızla evrilmiştir. HBM’nin tanıtımından bu yana, birçok nesil iyileşme yaşanmış, her bir iterasyon daha yüksek bant genişliği, artan kapasite ve enerjide verimlilik sağlamıştır. İlk HBM standardı, Samsung Electronics Co., Ltd. ve SK hynix Inc. tarafından Advanced Micro Devices, Inc. (AMD) ile işbirliği içinde geliştirilerek DRAM yongalarının dikey olarak yığılmasına ve bunların silikon içinden geçiş (TSV) ile bağlanmasına olanak tanımıştır; böylece geniş I/O ve düşük güç tüketimi sağlanmıştır.

HBM2 ve HBM2E standartları, JEDEC Solid State Technology Association tarafından onaylanmış ve yığın başına bant genişliği ile kapasiteyi artırarak pin başına 3.6 Gbps ve yığın başına 16 GB’ye kadar desteklemiştir. Bu iyileştirmeler, büyük veri setlerine ve modellere hızlı erişim gerektiren AI hızlandırıcıları için kritik öneme sahip olmuştur. 2022’de tanıtılan en son HBM3 standardı, pin başına 6.4 Gbps’in üzerine çıkarak ve yığın kapasitelerini 24 GB’a kadar artırarak performansı geliştirmiştir; Micron Technology, Inc. ve SK hynix Inc. gibi şirketler, HBM3 ürünlerini tanıtan ilk şirketler arasında yer almaktadır. 2025’te geniş ölçüde benimsenmesi beklenen HBM3E, daha yüksek hızlar ve geliştirilmiş termal yönetim sunması öngörülmektedir.

Mimari olarak, HBM’nin AI hızlandırıcılarıyla entegrasyonu, geleneksel yan yana PCB yerleştirmeden, silikon yerleştirme ve gelişmiş çiplet tasarımları gibi 2.5D ve 3D paketlemeye kaydırılmıştır. NVIDIA Corporation ve AMD, HBM’yi GPU ve AI hızlandırıcılarında kullanarak bu paketleme tekniklerini kullanarak sinyal kaybını en aza indirmekte ve bellek bant genişliğini maksimize etmektedir. Ko-paketlenmiş optiklerin ve üzerindeki bellek denetleyicilerinin benimsenmesi de artmakta; bu da gecikme ve güç tüketimini daha da azaltmaktadır.

2025’e doğru bakıldığında, HBM arayüz tasarım manzarası, ölçeklenebilirlik, enerji verimliliği ve entegrasyon esnekliğine odaklanmaktadır. Sektör liderleri, yeni standartlar ve referans mimariler üzerinde işbirliği yaparak birlikte çalışabilirliği sağlamakta ve AI model boyutu ve karmaşıklığındaki hızlı artışı desteklemeye yönelik çözümler geliştirmektedir. AI hızlandırıcıları performans sınırlarını zorlamaya devam ettikçe, HBM standartlarının ve mimarilerinin evrimi, alandaki yeniliklerin temel bir unsuru olmaya devam edecektir.

Rekabet Analizi: Önde Gelen Oyuncular ve İnovasyon Trendleri

AI hızlandırıcılarındaki Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımı için rekabet ortamı, yapay zeka iş yüklerinin artan talepleri ve bellek ile işlem birimleri arasındaki verimli, yüksek hızlı veri transferine olan ihtiyaç tarafından hızla evrim geçirmektedir. Samsung Electronics Co., Ltd., Micron Technology, Inc., ve SK hynix Inc. gibi önemli endüstri oyuncuları, HBM üretim sektöründe hakimiyet kurarak her biri, artırılmış bant genişliği, kapasite ve enerji verimliliği ile HBM2E, HBM3 ve sonrası nesillerini tanıtmaktadır.

AI hızlandırıcıları açısından, NVIDIA Corporation ve Advanced Micro Devices, Inc. (AMD) gibi şirketler, HBM’yi amiral gemisi GPU ve veri merkezi hızlandırıcılarına entegre ederek bellek geniş arayüzü ve 3D yığınlamadan yararlanarak derin öğrenme ve yüksek performanslı hesaplama uygulamalarındaki darboğazları en aza indirmektedir. Intel Corporation da HBM’yi AI ve HPC ürünlerinde benimseyerek daha düşük gecikme ve daha yüksek verimlilik için arayüzü optimize etmeye odaklanmıştır.

HBM arayüz tasarımındaki yenilik trendleri, enerji tüketimini azaltırken bant genişliğini maksimuma çıkarmaya odaklanmaktadır. İleri silikon içinden geçiş (TSV) mimarileri, geliştirilmiş sinyal bütünlüğü ve dinamik voltaj/sıklık ölçeklendirmesi gibi teknikler, bu zorlukları ele almak için uygulanmaktadır. JEDEC Solid State Technology Association tarafından yürütülen HBM3’ün benimsenmesi ve HBM4 standartlarının geliştirilmesi, bant genişliği sınırlarını zorlayarak HBM3’ün yığın başına hızlarının 800 GB/s’in üzerine çıkmayı hedeflemesini sağlamaktadır ve HBM4’ün bunu önemli ölçüde aşması beklenmektedir.

Bir diğer dikkat çekici trend, HBM’nin AI hızlandırıcılarıyla birlikte ko-paketlenmesidir; bu da 2.5D ve 3D entegrasyon gibi ileri paketleme teknolojileri kullanmaktadır. Tayvan Yarı İletken Üretim Şirketi (TSMC) ve Amkor Technology, Inc., bu paketleme çözümlerini sağlayarak daha yakın entegrasyon ve geliştirilmiş termal yönetim sağlamaktadır. Bu ko-tasarım yaklaşımı, bellek bant genişliği ve işlem birimlerine yakınlığın doğrudan performansı ve verimliliği etkilediği gelecek nesil AI sistemleri için kritik bir öneme sahiptir.

Özetle, AI hızlandırıcıları için HBM arayüz tasarımındaki rekabet dinamikleri, hızlı yenilikçilik, bellek ve çip üreticileri arasındaki stratejik ortaklıklar ve AI odaklı iş yüklerinin ihtiyaçlarını karşılamak için daha yüksek bant genişliği ve daha düşük güç çözümleri arayışı ile şekillenmektedir.

Pazar Büyüklüğü ve Tahmin (2025–2030): CAGR, Gelir Tahminleri ve Bölgesel Dağılım

AI hızlandırıcıları için Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımı pazarı, 2025 ile 2030 döneminde güçlü bir büyüme gösterecek gibi görünmektedir; bu, yapay zeka, makine öğrenimi ve veri merkezi uygulamalarında yüksek performanslı hesaplama ihtiyacının yükselmesinden kaynaklanmaktadır. Küresel HBM arayüz pazarının, bu dönemde yaklaşık %25–30 arasında bir bileşik yıllık büyüme oranı (CAGR) kaydetmesi beklenmektedir; bu, hem kurumsal hem de bulut ortamlarında HBM destekli AI hızlandırıcılarının hızlı benimsenmesini yansıtmaktadır.

Gelir tahminleri, pazar büyüklüğünün, 2025’te tahmini 2.5 milyar dolar olarak değerlendirilirken, 2030 yılına kadar 7.5 milyar doları aşabileceğini göstermektedir. Bu artış, üst düzey AI çiplerinde HBM entegrasyonunun artmasıyla ilişkilendirilmekte; bu çipler, büyük ölçekli paralel iş yüklerini işlemek için ultra hızlı bellek arayüzlerine ihtiyaç duymaktadır. Samsung Electronics Co., Ltd., Micron Technology, Inc. ve SK hynix Inc. gibi önemli endüstri oyuncuları, HBM arayüz teknolojilerinin geliştirilmesi için AR-GE’ye büyük yatırımlar yapmaktadır.

Bölgesel olarak, Asya-Pasifik’in HBM arayüz tasarım pazarında 2030 yılına kadar küresel gelirin %45’inden fazlasını olacağı beklenmektedir. Bu hakimiyet, Güney Kore, Tayvan ve Çin gibi ülkelerdeki büyük yarı iletken dökümhaneleri ve bellek üreticilerinin varlığına dayanmaktadır. Kuzey Amerika, AI hızlandırıcı geliştiricileri ve Amerika Birleşik Devletleri ile Kanada’daki hiperskal veri merkezleri ile desteklenerek hemen ardından gelmektedir. Avrupa da otomotiv AI ve endüstriyel otomasyon sektörlerinde özellikle sürekli bir büyüme göstermektedir.

Kenar hesaplama, otonom araçlar ve yüksek frekanslı ticaret gibi AI odaklı uygulamaların yaygınlaşması, gelişmiş HBM arayüzlerinin benimsenmesini hızlandırmaktadır. AI modelleri daha karmaşık ve veri yoğun hale geldikçe, daha yüksek bellek bant genişliği ve daha düşük gecikme ihtiyacı, çip tasarımcılarını JEDEC Solid State Technology Association tarafından tanımlanan HBM2E, HBM3 ve gelişmekte olan HBM4 standartlarını benimsemeye itmektedir.

Özetle, AI hızlandırıcıları için HBM arayüz tasarım pazarı 2030 yılına kadar önemli bir genişleme göstermeye hazırlanmakta; Asya-Pasifik ve Kuzey Amerika’da güçlü bölgesel büyüme ile birlikte daha yüksek bant genişliği ve daha enerji verimli bellek çözümlerine doğru belirgin bir eğilim gözlemlenmektedir.

Sürücüler ve Zorluklar: Performans Talepleri, Güç Verimliliği ve Entegrasyon Karmaşıklıkları

Yapay zeka (AI) iş yüklerinin hızlı evrimi, bellek alt sistemleri üzerinde eşi benzeri görülmemiş talepler oluşturmuş, Yüksek Bant Genişliği Belleği (HBM) gelecek nesil AI hızlandırıcıları için kritik bir etken haline gelmiştir. HBM arayüz tasarımının, özellikle performans, güç verimliliği ve entegrasyon karmaşıklığı alanlarında birkaç önemli sürücü ve zorluğu ele alması gereklidir.

Performans Talepleri: AI hızlandırıcıları, verileri yoğun bir şekilde işleyen hesaplama motorlarını beslemek için geniş bellek bant genişliği gerektirir; bu özellikle milyarlarca parametreye sahip derin öğrenme modelleri için geçerlidir. HBM, 3D yığınlanmış mimarisi ve geniş I/O ile birlikte son nesillerde 1 TB/s’in üzerinde bant genişlikleri sunmaktadır. Ancak, bunu pratikte gerçekleştirmek, düşük gecikmeyi minimize etmek, verimliliği maksimuma çıkarmak ve yüksek veri hızlarında sinyal bütünlüğünü sağlamak için dikkatli bir arayüz tasarımı gerektirmektedir. Arayüz ayrıca, AI iş yüklerinde yaygın olan büyük matris çarpımları ve tensör işlemleri gibi verimli veri hareket desenlerini desteklemelidir; bu durum bellek denetleyicileri ve ara bağlantılar üzerinde ek bir yük getirmektedir.

Güç Verimliliği: AI hızlandırıcıları ölçeklendikçe, güç tüketimi kritik bir kısıtlama haline gelir; bu, hem veri merkezi dağıtımları hem de kenar uygulamaları için geçerlidir. HBM’nin işleme birimine olan yakınlığı ve silikon içinden geçişler (TSV) kullanımı, geleneksel DDR belleğe kıyasla bit başına enerji tüketimini azaltmaktadır. Ancak, arayüz tasarımı, güç yönetimi becerilerini ve dinamik voltaj ve frekans ölçeklendirmesini kullanarak güç tüketimini daha da optimize etmelidir. Yüksek bant genişliğini düşük güç tüketimi ile dengelemek, bellek yığınları kapasite ve hızda büyüdükçe kalıcı bir zorluk haline gelir. Samsung Electronics Co., Ltd. ve Micron Technology, Inc. gibi kuruluşlar, enerji verimliliğini geliştirerek HBM nesillerini aktif bir şekilde geliştirmektedir.

Entegrasyon Karmaşıklıkları: HBM’nin AI hızlandırıcılarıyla entegrasyonu, önemli paketleme ve sistem seviyesi zorluklarını içermektedir. Bellek yongalarının fiziksel olarak yığılması ve bunların silikon yerleştiricileri veya gelişmiş alt tabakalar aracılığıyla işleme birimine bağlanması, hassas üretim ve termal yönetim gerektirir. Sinyal bütünlüğü, elektromanyetik parazit ve mekanik stres, güvenilir çalışma sağlamak için ele alınması gereken unsurlardır. Ayrıca, arayüz, JEDEC Solid State Technology Association tarafından tanımlanan evrilen standartlarla uyumlu olmalıdır; bu, birlikte çalışabilirlik ve gelecekteki ölçeklenebilirlik sağlamaktadır. Entegrasyon karmaşıklığı, hızlandırıcıların çiplet tabanlı mimarilere geçmesiyle arttığından, heterojen entegrasyonu destekleyebilecek güçlü HBM arayüz çözümleri gerekmektedir.

Özetle, 2025’te AI hızlandırıcıları için HBM arayüz tasarımı, aşırı bant genişliği sunma, güç verimliliğini koruma ve gelişmiş entegrasyon karmaşıklığı yönetme gereksinimlerinden şekillenmektedir; tüm bunlar AI donanımındaki hızlı yeniliklere ayak uydurmayı hedeflemektedir.

Yeni Uygulamalar: AI, HPC, Veri Merkezleri ve Kenar Hesaplama

Yapay zeka (AI), yüksek performanslı hesaplama (HPC), veri merkezleri ve kenar hesaplama alanlarındaki hızlı evrim, bellek bant genişliği ve verimliliği için eşi benzeri görülmemiş bir talep yaratmaktadır. Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımı, AI hızlandırıcıları için temel bir teknoloji haline gelmiştir ve modern derin öğrenme ile analiz iş yüklerinin gerektirdiği büyük ölçekli paralellik ve veri akışını sağlamaktadır. HBM, birden fazla DRAM yongasını dikey olarak yığarak ve bunları silikon içinden geçişler (TSV) ile bağlayarak bunu başarmaktadır, sonuç olarak geleneksel bellek arayüzlerine kıyasla çok daha yüksek bant genişlikleri ve daha düşük güç tüketimi elde edilmektedir.

AI hızlandırıcılarında, NVIDIA Corporation ve Advanced Micro Devices, Inc. (AMD) tarafından geliştirilenler gibi, HBM arayüzleri, binlerce işlem çekirdeğine veri beslemek için kritik öneme sahiptir. JEDEC Solid State Technology Association tarafından tanımlanan en son HBM3 ve HBM3E standartları, yığın başına 1 TB/s’i aşan bant genişliklerini desteklemektedir; bu, büyük ölçekli sinir ağlarını eğitmek ve veri merkezlerinde gerçek zamanlı çıkarım yapmak için gereklidir. Bu arayüzler, sinyal kaybını ve gecikmeyi en aza indirgeyerek hızlandırıcı yongasıyla sıkı bir şekilde entegre edilmiştir.

HPC ortamlarında HBM’nin yüksek bant genişliği ve enerji verimliliği, bilimsel simülasyonların, finansal modellemenin ve diğer veri yoğun görevlerin hızlandırılmasında kullanılmaktadır. Cray Inc. ve Fujitsu Limited tarafından inşa edilen süper bilgisayarlar, petaflop ve exaflop performans hedeflerine ulaşmak için HBM destekli işlemciler kullanmaktadır. Arayüz tasarımı, zorlu iş yükleri altında güvenilir çalışma sağlamak için sinyal bütünlüğü, termal yönetim ve hata düzeltme gibi zorlukları ele almalıdır.

Kenar hesaplama cihazları, kompakt form faktörleri ve düşük güç tüketimi gerektirdiğinden, HBM arayüzlerini benimsemeye de başlamaktadır. Samsung Electronics Co., Ltd. ve SK hynix Inc. gibi şirketler, kenar AI çipleri için bellek bant genişliği ihtiyaçlarını, enerji ve termal kısıtlamalarla dengeleyen HBM çözümleri geliştirmektedir.

2025’te, HBM arayüz tasarımının sürekli olarak geliştirilmesi, AI, HPC ve kenar uygulamalarının bir sonraki neslini desteklemede temel bir rol oynayacaktır. Paketleme, sinyal verme ve bellek denetleyici mimarilerindeki yenilikler, AI hızlandırıcılarının ölçeklenebilirliğini ve verimliliğini daha da artıracak; bellek bant genişliğinin hesaplama talebindeki hızlı artışla uyumlu olmasını sağlayacaktır.

Tedarik Zinciri ve Ekosistem Analizi

Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımı için tedarik zinciri ve ekosistem, yarı iletken üreticileri, bellek tedarikçileri, dökümhaneler ve tasarım aracı sağlayıcılarından oluşan karmaşık bir ağ ile karakterize edilmektedir. HBM, dikey olarak yığılmış DRAM yongaları ve geniş arayüzü ile AI hızlandırıcıları için kritik bir etken olup, büyük ölçekli makine öğrenimi iş yükleri için gereken bant genişliği ve enerji verimliliğini sunmaktadır. HBM arayüzlerinin tasarımı ve entegrasyonu, bellek sağlayıcıları olan Samsung Electronics Co., Ltd., Micron Technology, Inc., ve SK hynix Inc. ile önde gelen AI çip tasarımcıları olan NVIDIA Corporation ve Advanced Micro Devices, Inc. (AMD) arasında yakın işbirliğini gerektirmektedir.

Ekosistem, Tayvan Yarı İletken Üretim Şirketi (TSMC) ve Intel Corporation gibi dökümhaneler tarafından sağlanan, silikon yerleştiricileri ve 2.5D/3D entegrasyon gibi ileri paketleme ve ara bağlantı teknolojileri ile desteklenmektedir. Bu dökümhaneler, HBM yığınlarının mantık yongaları ile fiziksel entegrasyonunu sağlayarak, yüksek veri hızlarında sinyal bütünlüğü ve termal yönetimi sağlamaktadır. Synopsys, Inc. ve Cadence Design Systems, Inc. gibi EDA araç sağlayıcıları, HBM arayüzlerinin sıkı zamanlama, güç ve güvenilirlik gereksinimlerini karşılamak için özel IP ve doğrulama çözümleri sunmaktadır.

Standartlaştırma çabaları, JEDEC Solid State Technology Association gibi kuruluşlar tarafından yürütülen HBM arayüz spesifikasyonlarını belirlemek ve tedarik zincirinde birlikte çalışabilirliği sağlamak açısından kritik bir rol oynamaktadır. HBM standartlarının (örn. HBM3, HBM3E) hızlı evrimi, ekosistem katılımcılarının tasarım akışlarını ve üretim süreçlerini sürekli güncellemelerini gerektirmektedir. Ayrıca, veri merkezlerinde ve kenar cihazlarda AI hızlandırıcılarına olan talebin artması, kapasite genişletme ve tedarik zinciri dayanıklılığına yatırım yapılmasını teşvik etmektedir; bu da büyük bellek ve dökümhane ortaklarından gelen son duyurularda gözlemlenmektedir.

Özetle, 2025 yılı için AI hızlandırıcıları için HBM arayüz tasarım ekosistemi, bellek tedarikçileri, çip tasarımcıları, dökümhaneler, EDA tedarikçileri ve standart kuruluşları arasında derin karşılıklı bağımlılıklarla işaretlenmektedir. Bu işbirlikçi ortam, gelecek nesil AI iş yüklerini destekleyen yüksek performanslı, enerji verimli bellek alt sistemlerini sağlamada hayati öneme sahiptir.

Gelecek Beklentisi: Yıkıcı Teknolojiler ve Gelecek Nesil HBM Arayüzleri

Yüksek Bant Genişliği Belleği (HBM) arayüz tasarımının geleceği, yıkıcı teknolojiler ve bir sonraki nesil HBM standartlarının evrimi tarafından önemli bir dönüşüm sürecine girmektedir. AI iş yükleri daha yüksek bellek bant genişliği ve daha düşük gecikme talep etmeye devam ederken, sektör HBM2E ve HBM3’ün ötesine geçerek HBM3E ve HBM4’e yönelik erken araştırmalar gibi daha gelişmiş çözümler arayışındadır. Bu yeni standartlar, HBM3E’nin pin başına 9.2 Gbps’e kadar hız hedeflemesi ve yığın başına toplam bant genişliğinin 1.2 TB/s’i aşması gibi hiç görülmemiş veri oranları vaat etmektedir; bu, ölçekli AI eğitim ve çıkarım için kritik bir ilerlemedir (Samsung Electronics).

Yıkıcı arayüz teknolojileri de, daha fazla bellek yongası yığmanın ve I/O yoğunluğunu artırmanın getirdiği sinyal bütünlüğü, güç dağıtımı ve termal yönetim zorluklarını ele almak için ortaya çıkmaktadır. Gelişmiş silikon içinden geçiş (TSV) mimarileri, geliştirilmiş yerleştirici malzemeler ve çiplet tabanlı tasarımların benimsenmesi, AI hızlandırıcıları ile HBM yığınları arasında daha sıkı bir entegrasyon sağlamaktadır. Örneğin, silikon köprüler ve organik yerleştiricilerin kullanımı, maliyetleri azaltmak ve ölçeklenebilirliği artırmak amacıyla incelenmektedir; bu, gelecek nesil HBM’nin gerektirdiği yüksek hızlı sinyalleşmeyi sürdürebilmektedir (Advanced Micro Devices, Inc.).

Geleceğe bakıldığında, HBM’nin 2.5D ve 3D paketleme gibi yeni AI hızlandırıcı mimarileriyle entegrasyonu, bellek ile hesaplama arasındaki sınırları daha da belirsiz hale getirecektir. Bu ko-paketleme yaklaşımının, veri hareketini en aza indireceği, enerji tüketimini azaltacağı ve büyük dil modelleri ve üretken AI iş yükleri için yeni seviyelerde paralellik açacağı tahmin edilmektedir. Sektör liderleri, bellek bant genişlikleri yükseldikçe güvenilirlik ve ölçeklenebilirliği sağlamak için yeni arayüz protokolleri ve hata düzeltme şemaları üzerinde de işbirliği yapmaktadır (Micron Technology, Inc.).

Özetle, AI hızlandırıcıları için HBM arayüz tasarımının geleceği, bellek teknolojisindeki hızlı ilerlemeler, paketleme yenilikleri ve sistem düzeyinde ortak tasarım ile şekillenecektir. Bu gelişmeler, 2025 ve sonrasında AI donanımının performans sınırlarını yeniden tanımlayarak, makine öğrenimi ve veri analitiğinde bir sonraki büyük sıçramayı mümkün kılacaktır.

Paydaşlar için Stratejik Öneriler

AI hızlandırıcıları, büyük ölçekli makine öğrenimi ve derin öğrenme iş yüklerinin taleplerini karşılamak için yüksek bant genişliği belleği (HBM) üzerine giderek daha fazla bağımlı hale geldikçe, paydaşların—çip tasarımcıları, sistem entegratörleri ve veri merkezi operatörleri dahil—HBM arayüz tasarımını optimize etmek için ileri görüşlü stratejiler benimsemesi gerekecektir. Aşağıdaki öneriler, 2025 ve sonrasında AI donanımında HBM entegrasyonunun gelişen manzarasını ele almak üzere hazırlanmıştır.

- Bellek ve Hesaplamanın Ko-Tasarımını Önceliklendirin: Bellek ve hesaplama ekipleri arasında işbirlikçi geliştirme esastır. HBM arayüzünü, AI hızlandırıcısının mimarisi ile birlikte optimum hale getirerek, paydaşlar gecikmeyi azaltabilir ve verimliliği artırabilir. Samsung Electronics Co., Ltd. ve Micron Technology, Inc., en son HBM çözümlerinde bu tür entegre yaklaşımların faydalarını göstermiştir.

- En Son HBM Standartlarını Benimseyin: HBM3 ve gelişmekte olan HBM4 gibi en son HBM standartlarıyla güncel kalmak, uyumluluk sağlar ve daha yüksek bant genişlikleri ile geliştirilmiş enerji verimliliğine erişim sağlar. JEDEC Solid State Technology Association, bu standartları düzenli olarak güncellemektedir; erken benimseme rekabet avantajı sağlayabilir.

- Gelişmiş Paketleme Teknolojilerine Yatırım Yapın: 2.5D ve 3D entegrasyon, silikon yerleştiriciler ve silikon içinden geçişler (TSV) gibi, verimli HBM arayüz tasarımı için kritik öneme sahiptir. Tayvan Yarı İletken Üretim Şirketi (TSMC) gibi paketleme uzmanlarıyla işbirliği yapmak, paydaşların en son ara bağlantı çözümlerinden yararlanmasına yardımcı olabilir.

- Güç Dağıtımını ve Termal Yönetimi Optimize Edin: HBM yığınları yoğunluğunu ve hızını artırdıkça, güç dağıtımı ve ısı dağılımı daha da zorlaşmaktadır. Paydaşlar, yenilikçi soğutma çözümleri için CoolIT Systems Inc. gibi ortaklarla çalışarak, gelişmiş güç yönetimi IC’lerine yatırım yapmalıdır.

- Ekosistem İşbirliğini Teşvik Edin: OIF (Optical Internetworking Forum) gibi endüstri konsorsiyumları ve standart kuruluşları ile etkileşim kurmak, paydaşların arayüz yenilikleri ve birlikte çalışabilirlik gereksinimleri konusunda güncel kalmasına yardımcı olabilir.

Bu stratejik önerileri uygulayarak, paydaşlar AI hızlandırıcıları için HBM arayüz tasarımlarının sağlam, ölçeklenebilir ve geleceğe dönük olmasını sağlayabilirler; böylece AI iş yüklerinin bir sonraki neslini destekleyebilirler.

Kaynaklar & Referanslar

- Micron Technology, Inc.

- NVIDIA Corporation

- JEDEC Solid State Technology Association

- Amkor Technology, Inc.

- Cray Inc.

- Fujitsu Limited

- Synopsys, Inc.

- OIF (Optical Internetworking Forum)