Åbning af kraften i høj-båndbredde hukommelse: Hvordan HBM-interface design revolutionerer AI-acceleratorer i 2025 og fremover. Udforsk teknologierne, markedsvæksten og strategiske muligheder, der former den næste æra af AI-hardware.

- Resumé: Nøglefund og strategiske indsigter

- Markedsoversigt: HBM-interface design for AI-acceleratorer i 2025

- Technologilandskab: Udviklingen af HBM-standarder og -arkitekturer

- Konkurrenceanalyse: Ledende aktører og innovationstrends

- Markedsstørrelse og prognose (2025–2030): CAGR, indtægtsprognoser og regional opdeling

- Drivere og udfordringer: Præstationskrav, energieffektivitet og integrationskompleksiteter

- Fremvoksende applikationer: AI, HPC, datacentre og edge computing

- Forsyningskæde- og økosystemanalyse

- Fremtidige udsigter: Disruptive teknologier og næste generations HBM-interfaces

- Strategiske anbefalinger til interessenter

- Kilder & Referencer

Resumé: Nøglefund og strategiske indsigter

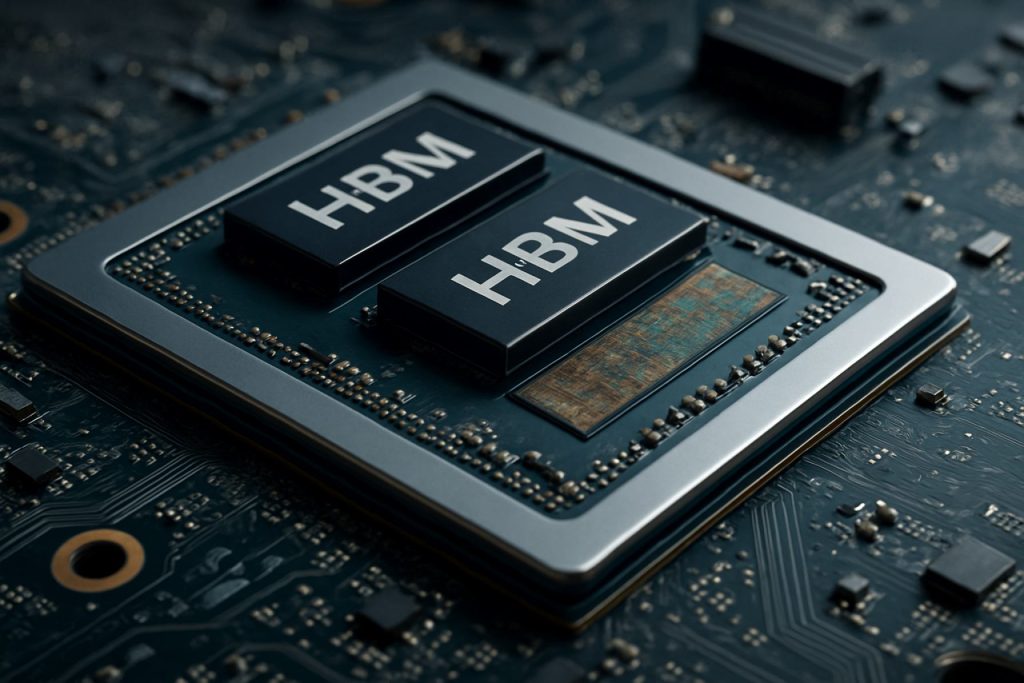

Høj-båndbredde hukommelse (HBM) interface design er blevet en kritisk mulighed for næste generations AI-acceleratorer og adresserer de stigende krav til hukommelsesbåndbredde, energieffektivitet og kompakte formfaktorer i datakrævende applikationer. I 2025 har den hurtige udvikling af AI-arbejdsbelastninger—især inden for dyb læring og store sprogmodeller—intensificeret behovet for hukommelsesløsninger, der kan levere terabyte pr. sekund i båndbredde, samtidig med at latenstid og strømforbrug minimeres. HBM, med sin 3D-stakede arkitektur og gennem-silikon-via (TSV) teknologi, er blevet den foretrukne hukommelsesgrænseflade for førende AI-acceleratorleverandører.

Nøglefund indikerer, at adoptionen af HBM3 og den forventede udrulning af HBM4 sætter nye benchmark i båndbredde, med HBM3 som tilbyder op til 819 GB/s pr. stak og HBM4 som forventes at overstige 1 TB/s. Disse fremskridt muliggør for AI-acceleratorer at behandle større datasæt i realtid, hvilket signifikant forbedrer trænings- og inferensthrouput. Større industrispillere såsom Samsung Electronics Co., Ltd., Micron Technology, Inc., og SK hynix Inc. er i front med HBM-innovation og samarbejder tæt med AI-hardwaredesignere for at optimere interfaceprotokoller og signalintegritet.

Strategiske indsigter viser, at succesfuldt HBM-interface design afhænger af flere faktorer: avancerede pakningsteknikker (såsom 2.5D og 3D integration), robust termisk styring og co-design af hukommelseskontrollere med AI-behandlingskerner. Virksomheder som Advanced Micro Devices, Inc. og NVIDIA Corporation udnytter disse strategier til at levere AI-acceleratorer med hidtil uset præstation pr. watt. Desuden vinder integreringen af HBM med chiplet-baserede arkitekturer også frem, hvilket tilbyder modularitet og skalerbarhed til fremtidige AI-systemer.

Set i fremtiden forventes HBM-interface økosystemet at drage fordel af standardiseringstiltag ledet af organisationer som JEDEC Solid State Technology Association, som strømliner interoperabilitet og fremskynder tid til markedet for nye hukommelsesløsninger. Efterhånden som AI-modeller fortsætter med at vokse i kompleksitet, vil den strategiske tilpasning af HBM-interface design med de udviklende AI-arbejdsbelastninger være essentiel for at opretholde en konkurrencefordel i AI-hardwarelandskabet.

Markedsoversigt: HBM-interface design for AI-acceleratorer i 2025

Markedet for High-Bandwidth Memory (HBM) interface design i AI-acceleratorer er klar til betydelig vækst i 2025, drevet af de stigende beregningskrav fra kunstig intelligens og maskinlæringsarbejdsbelastninger. HBM, en 3D-stakket DRAM-teknologi, tilbyder betydelige forbedringer i hukommelsesbåndbredde og energieffektivitet sammenlignet med traditionelle hukommelsesløsninger, hvilket gør den til en kritisk muliggører for næste generations AI-acceleratorer.

I 2025 bliver adoptionen af HBM-interfaces accelereret af førende halvlederrproducenter og hyperskala datacenteroperatører, der ønsker at overvinde hukommelsesflaskehalse, der er iboende i AI-træning og inferensopgaver. De nyeste HBM-standarder, såsom HBM3 og den kommende HBM3E, leverer båndbredder over 1 TB/s pr. enhed, hvilket understøtter de parallelle behandlingskrav for store sprogmodeller og generative AI-systemer. Virksomheder som Samsung Electronics Co., Ltd., Micron Technology, Inc., og SK hynix Inc. er i front med HBM-udvikling, og leverer hukommelsesløsninger, der hurtigt integreres i AI-acceleratordesigns.

Interface design for HBM i AI-acceleratorer bliver stadig mere komplekst og kræver avancerede pakningsteknologier, såsom 2.5D og 3D integration. Disse tilgange muliggør den tætte fysiske nærhed af HBM-stakke til behandlingsenheder, hvilket minimerer latenstid og maksimerer datapåfyldning. Halvlederfabrikker som Taiwan Semiconductor Manufacturing Company Limited (TSMC) og Intel Corporation investerer i avancerede interposer- og pakningsløsninger for at støtte disse arkitekturer.

Efterspørgslen efter HBM-aktiverede AI-acceleratorer er særlig stærk i cloud datacentre, edge computing og højtydende beregningssektorer. Store AI-chipudbydere, herunder NVIDIA Corporation og Advanced Micro Devices, Inc. (AMD), integrerer HBM i deres flagskibsprodukter for at levere den nødvendige hukommelsesbåndbredde til topmoderne AI-modeller. Det konkurrenceprægede landskab formes yderligere af udviklende standarder fra organisationer som JEDEC Solid State Technology Association, som fortsætter med at definere nye HBM-specifikationer for at imødekomme fremtidige AI-krav.

Samlet set er markedet for HBM-interface design for AI-acceleratorer i 2025 præget af hurtig innovation, strategiske partnerskaber på tværs af halvlederforsyningskæden og en vedholdende fokus på båndbredde, energieffektivitet og skalerbarhed for at støtte den næste bølge af AI-fremskridt.

Technologilandskab: Udviklingen af HBM-standarder og -arkitekturer

Technologilandskabet for High-Bandwidth Memory (HBM) interface design har hurtigt udviklet sig for at imødekomme de stigende krav fra AI-acceleratorer. Siden sin introduktion har HBM gennemgået flere generationsforbedringer, hver iteration har leveret højere båndbredde, øget kapacitet og forbedret energieffektivitet. Den første HBM-standard, udviklet af Samsung Electronics Co., Ltd. og SK hynix Inc. i samarbejde med Advanced Micro Devices, Inc. (AMD), lagde grunden til lodning af DRAM-dies vertikalt og forbinde dem med gennem-silikon vias (TSVs), hvilket gjorde det muligt for bred I/O og lavt strømforbrug.

HBM2 og HBM2E standarder, som er ratificeret af JEDEC Solid State Technology Association, øgede yderligere båndbredde og kapacitet pr. stak, hvilket støtter op til 3,6 Gbps pr. pin og 16 GB pr. stak. Disse forbedringer var kritiske for AI-acceleratorer, som kræver hurtig adgang til store datasæt og modeller. Den nyeste HBM3-standard, introduceret i 2022, skubber båndbredden til over 6,4 Gbps pr. pin og stakkapaciteter op til 24 GB, med Micron Technology, Inc. og SK hynix Inc. blandt de første til at annoncere HBM3-produkter. HBM3E, som forventes at blive bredt adopteret i 2025, forventes at levere endnu højere hastigheder og forbedret termisk styring, der adresserer behovene hos næste generations AI-arbejdsbelastninger.

Arkitektonisk er integrationen af HBM med AI-acceleratorer skiftet fra traditionel side-om-side PCB-placering til 2.5D og 3D pakning, som siliciuminterposere og avancerede chipletdesign. NVIDIA Corporation og AMD har været pionerer inden for brugen af HBM i deres GPU’er og AI-acceleratorer og udnytter disse pakningsteknikker for at minimere signaltab og maksimere hukommelsesbåndbredde. Adoptionen af co-pakket optik og on-die hukommelseskontrollere er også ved at blive populær, og reducerer yderligere latenstid og strømforbrug.

Set frem mod 2025 er HBM-interface designlandskabet præget af fokus på skalerbarhed, energieffektivitet og integrationsfleksibilitet. Brancheledere samarbejder om nye standarder og referencearkitekturer for at sikre interoperabilitet og støtte den eksponentielle vækst i AI-model størrelse og kompleksitet. Efterhånden som AI-acceleratorer fortsætter med at presse grænserne for ydeevnen, forbliver udviklingen af HBM-standarder og -arkitekturer en hjørnesten for innovation i feltet.

Konkurrenceanalyse: Ledende aktører og innovationstrends

Det konkurrenceprægede landskab for High-Bandwidth Memory (HBM) interface design i AI-acceleratorer udvikler sig hurtigt, drevet af de stigende krav fra kunstige intelligensarbejdsbelastninger og behovet for effektiv, højhastighedsoverførsel mellem hukommelse og behandlingsenheder. Nøgleindustrispillere som Samsung Electronics Co., Ltd., Micron Technology, Inc., og SK hynix Inc. dominerer HBM-produktionssektoren og introducerer hver efterfølgende generation af HBM (HBM2E, HBM3 og derover) med øget båndbredde, kapacitet og energieffektivitet.

På AI-acceleratorfronten har virksomheder som NVIDIA Corporation og Advanced Micro Devices, Inc. (AMD) integreret HBM i deres flagskibs-GPU’er og datacenteracceleratorer og udnyttet hukommelsens brede interface og 3D-stak for at minimere flaskehalse i dyb læring og højtydende beregningsapplikationer. Intel Corporation har også adopteret HBM i sine AI- og HPC-produkter og fokuserer på at optimere grænsefladen for lavere latenstid og højere throughput.

Innovationsstrækkene inden for HBM-interface design er centreret om at maksimere båndbredden, mens man reducerer strømforbruget og den fysiske fodaftryk. Teknikker som avancerede gennem-silikon vias (TSV) arkitekturer, forbedret signalintegritet, og dynamisk spændings/frekvens skalering implementeres for at imødekomme disse udfordringer. Adoptionen af HBM3 og udviklingen af HBM4-standarder, ledet af JEDEC Solid State Technology Association, presser båndbredderne for hukommelse, med HBM3 der retter sig mod hastigheder over 800 GB/s pr. stak og HBM4, der forventes at overgå dette betydeligt.

En anden bemærkelsesværdig trend er co-pakning af HBM med AI-acceleratorer ved hjælp af avancerede pakningsteknologier som 2.5D og 3D integration. Taiwan Semiconductor Manufacturing Company Limited (TSMC) og Amkor Technology, Inc. er i front med at levere disse pakningsløsninger, hvilket muliggør tættere integration og forbedret termisk styring. Denne co-design tilgang er kritisk for næste generations AI-systemer, hvor hukommelsesbåndbredde og nærhed til beregningsenheder direkte påvirker ydeevnen og effektiviteten.

Sammenfattende er de konkurrenceprægede dynamikker i HBM-interface design for AI-acceleratorer formet af hurtig innovation, strategiske partnerskaber mellem hukommelse- og chipproducenter og den vedholdende jagt på højere båndbredde og lavere strøm-løsninger for at imødekomme behovene fra AI-drevne arbejdsbelastninger.

Markedsstørrelse og prognose (2025–2030): CAGR, indtægtsprognoser og regional opdeling

Markedet for High-Bandwidth Memory (HBM) interface design i AI-acceleratorer er klar til solid vækst mellem 2025 og 2030, drevet af stigende efterspørgsel efter højtydende computing i kunstig intelligens, maskinlæring, og datacenter applikationer. Det globale HBM-interface marked forventes at registrere en sammensat årlig væksttakt (CAGR) på omkring 25–30% i denne periode, hvilket afspejler den hurtige adoption af HBM-aktiverede AI-acceleratorer i både virksomhed og cloud-miljøer.

Indtægtsprognoser indikerer, at markedsstørrelsen, vurderet til cirka 2,5 milliarder USD i 2025, kan overstige 7,5 milliarder USD inden 2030. Denne stigning tilskrives den stigende integration af HBM i næste generations AI-chips, som kræver ultrahurtige hukommelsesinterfaces for at håndtere massive parallelle behandlingsarbejder. Nøgleindustrispillere som Samsung Electronics Co., Ltd., Micron Technology, Inc., og SK hynix Inc. investerer kraftigt i F&U for at fremme HBM-interface teknologier, hvilket yderligere fremmer markedets ekspansion.

Regionalt forventes Asien-Stillehavsområdet at dominere HBM-interface designmarkedet og tegne sig for over 45% af den globale indtægt inden 2030. Denne dominans støttes af tilstedeværelsen af større halvlederfabrikker og hukommelsesproducenter i lande som Sydkorea, Taiwan, og Kina. Nordamerika følger nært efter, drevet af koncentrationen af AI-acceleratorudviklere og hyperskala datacentre i USA og Canada. Europa oplever også stabil vækst, især inden for automobil-AI og industriautomatiseringssektorer.

Udbredelsen af AI-drevne applikationer i edge computing, autonome køretøjer og højfrekvente handler accelererer yderligere adoptionen af avancerede HBM-interfaces. Efterhånden som AI-modeller bliver mere komplekse og datakrævende, presser behovet for højere hukommelsesbåndbredde og lavere latenstid chipdesignere til at adoptere HBM2E, HBM3 og kommende HBM4-standarder, som er defineret af JEDEC Solid State Technology Association.

Sammenfattende er markedet for HBM-interface design for AI-acceleratorer indstillet til betydelig udvidelse indtil 2030, med stærk regional vækst i Asien-Stillehavsområdet og Nordamerika, samt en klar tendens mod højere båndbredde og mere energieffektive hukommelsesløsninger.

Drivere og udfordringer: Præstationskrav, energieffektivitet og integrationskompleksiteter

Den hurtige udvikling af kunstige intelligens (AI) arbejdsbelastninger har lagt hidtil usete krav på hukommelsessubsystemer, hvilket gør Høj-båndbredde Hukommelse (HBM) til en kritisk mulighed for næste generations AI-acceleratorer. Designet af HBM interfaces skal adressere flere nøgledrivere og udfordringer, især inden for områderne præstation, energieffektivitet og integrationskompleksitet.

Præstationskrav: AI-acceleratorer kræver massiv hukommelsesbåndbredde for at forsyne datahungrende beregningsmotorer, især for dybe læringsmodeller med milliarder af parametre. HBM, med sin 3D-stakede arkitektur og brede I/O, tilbyder båndbredder over 1 TB/s i de nyeste generationer. Det kræver imidlertid omhyggeligt interface design at opnå dette i praksis for at minimere latenstid, maksimere throughput og sikre signalintegritet ved høje datarater. Interface skal også understøtte effektive databevægelsesmønstre, der typisk forekommer i AI-arbejdsbelastninger, såsom store matrixmultiplikationer og tensoroperationer, som lægger ekstra pres på hukommelseskontrollere og interconnects.

Energieffektivitet: Efterhånden som AI-acceleratorer skaleres, bliver strømforbruget en kritisk begrænsning, både for datacenterimplementeringer og edge-applikationer. HBM’s nærhed til processoren og dens brug af gennem-silikon vias (TSV) reducerer energi pr. bit sammenlignet med traditionel DDR-hukommelse. Ikke desto mindre skal interface designet yderligere optimere strøm ved at anvende avancerede signaleringsteknikker, dynamisk spænding og frekvensskala samt intelligent strømstyring. At balancere høj båndbredde med lav strømoperation er en vedvarende udfordring, især efterhånden som hukommelsestakkene vokser i kapacitet og hastighed. Organisationer som Samsung Electronics Co., Ltd. og Micron Technology, Inc. udvikler aktivt nye HBM-generationer med forbedret energieffektivitet.

Integrationskompleksiteter: Integration af HBM med AI-acceleratorer involverer betydelige pakke- og systemniveau udfordringer. Den fysiske stakning af hukommelseschips og deres forbindelse til processoren via siliciuminterposere eller avancerede substrater kræver præcisionsfremstilling og termisk styring. Signalintegritet, elektromagnetisk interferens og mekanisk stress skal alle adresseres for at sikre pålidelig drift. Desuden skal interface være kompatible med udviklende standarder, såsom dem der er defineret af JEDEC Solid State Technology Association, for at sikre interoperabilitet og fremtidig skalerbarhed. Kompleksiteten stiger, efterhånden som acceleratoren adopterer chiplet-baserede arkitekturer, hvilket nødvendiggør robuste HBM-interface løsninger, der kan understøtte heterogen integration.

Sammenfattende er designet af HBM interfaces for AI-acceleratorer i 2025 præget af behovet for at levere ekstrem båndbredde, opretholde energieffektivitet og håndtere kompleksiteterne ved avanceret integration, alt imens man holder sig ajour med den hurtige innovation inden for AI-hardware.

Fremvoksende applikationer: AI, HPC, datacentre og edge computing

Den hurtige udvikling af kunstig intelligens (AI), højtydende computing (HPC), datacentre og edge computing driver en hidtil uset efterspørgsel efter hukommelsesbåndbredde og effektivitet. Høj-båndbredde hukommelse (HBM) interface design er blevet en hjørnesten teknologi for AI-acceleratorer, der muliggør det massive parallelisme og datagennemstrømning, der kræves af moderne dyb læring og analysearbejdsbelastninger. HBM opnår dette ved at stable flere DRAM-dies vertikalt og forbinde dem med gennem-silikon vias (TSVs), hvilket resulterer i betydeligt højere båndbredde og lavere strømforbrug sammenlignet med traditionelle hukommelsesinterfaces.

I AI-acceleratorer, såsom dem udviklet af NVIDIA Corporation og Advanced Micro Devices, Inc. (AMD), er HBM-interfaces kritiske for at forsyne data til tusinder af behandlingskerner uden flaskehalse. De nyeste HBM3 og HBM3E standarder, som defineret af JEDEC Solid State Technology Association, understøtter båndbredder, der overstiger 1 TB/s pr. stak, hvilket er essentielt for træning af store neurale netværk og realtidsinferens i datacentre. Disse interfaces er tæt integreret med accelerator die ved hjælp af avancerede pakningsteknikker som 2.5D og 3D integration, hvilket minimerer signaltab og latenstid.

I HPC-miljøer udnyttes HBM’s høje båndbredde og energieffektivitet til at accelerere videnskabelige simulationer, finansielle modeller og andre datakrævende opgaver. Supercomputere som dem bygget af Cray Inc. og Fujitsu Limited anvender HBM-aktiverede processorer for at nå petascale og exascale performance mål. Interface designet skal adressere udfordringer som signalintegritet, termisk styring og fejlkorrigering for at sikre pålidelig drift under ekstreme arbejdsbelastninger.

Edge computing-enheder, som kræver kompakte formfaktorer og lavt strømforbrug, begynder også at adoptere HBM-interfaces. Virksomheder som Samsung Electronics Co., Ltd. og SK hynix Inc. udvikler HBM-løsninger tilpasset edge AI-chips, der balancerer båndbreddebehov med strenge strøm- og termiske begrænsninger.

Set frem mod 2025 vil den fortsatte forbedring af HBM-interface design være afgørende for at støtte næste generation af AI-, HPC- og edge-applikationer. Innovationer inden for pakning, signalering og hukommelseskontrollerarkitekturer vil yderligere forbedre skalerbarheden og effektiviteten af AI-acceleratorer, hvilket sikrer, at hukommelsesbåndbredden holder trit med den eksponentielle vækst i beregningskrav.

Forsyningskæde- og økosystemanalyse

Forsyningskæden og økosystemet for High-Bandwidth Memory (HBM) interface design i AI-acceleratorer er præget af et komplekst netværk af halvlederproducenter, hukommelsesleverandører, fabrikker og designværktøjsudbydere. HBM, med sine vertikalt stabelde DRAM-dies og brede interface, er en kritisk muliggører for AI-acceleratorer og tilbyder den båndbredde og energieffektivitet, der kræves til omfattende maskinlæringsarbejdsbelastninger. Designet og integrationen af HBM-interfaces kræver tæt samarbejde mellem hukommelsesleverandører, såsom Samsung Electronics Co., Ltd., Micron Technology, Inc., og SK hynix Inc., og førende AI-chipdesignere som NVIDIA Corporation og Advanced Micro Devices, Inc. (AMD).

Økosystemet understøttes yderligere af avancerede paknings- og interconnect-teknologier, såsom siliciuminterposere og 2.5D/3D integration, som leveres af fabrikker som Taiwan Semiconductor Manufacturing Company Limited (TSMC) og Intel Corporation. Disse fabrikker muliggør den fysiske integration af HBM-stakke med logiske dies og sikrer signalintegritet og termisk styring ved høje datarater. EDA-værktøjsudbydere, herunder Synopsys, Inc. og Cadence Design Systems, Inc., tilbyder specialiserede IP- og verificeringsløsninger til at imødekomme de strenge tids-, strøm- og pålidelighedskrav til HBM-interfaces.

Standardiseringstiltag, ledet af organisationer som JEDEC Solid State Technology Association, spiller en afgørende rolle i at definere HBM-interface specifikationer og sikre interoperabilitet på tværs af forsyningskæden. Den hurtige udvikling af HBM-standarder (f.eks. HBM3, HBM3E) kræver, at økosystemets deltagere løbende opdaterer deres designflows og fremstillingsprocesser. Desuden presser den stigende efterspørgsel efter AI-acceleratorer i datacentre og edge-enheder investeringer i kapacitetsudvidelse og forsyningskæde-resiliens, som set i de seneste annonceringer fra store hukommelses- og fabrikspartnere.

Sammenfattende er HBM-interface design økosystemet for AI-acceleratorer i 2025 præget af dybe indbyrdes afhængigheder blandt hukommelsesleverandører, chipdesignere, fabrikker, EDA-udbydere og standardiseringsorganer. Dette samarbejdsmiljø er essentielt for at levere de højtydende, energieffektive hukommelsessubsystemer, der understøtter næste generations AI-arbejdsbelastninger.

Fremtidige udsigter: Disruptive teknologier og næste gens HBM-interfaces

Fremtiden for High-Bandwidth Memory (HBM) interface design for AI-acceleratorer er klar til betydelig transformation, drevet af disruptive teknologier og udviklingen af næste generations HBM-standarder. Efterhånden som AI-arbejdsbelastninger fortsætter med at kræve højere hukommelsesbåndbredde og lavere latenstid, bevæger industrien sig væk fra HBM2E og HBM3 mod endnu mere avancerede løsninger som HBM3E og tidlig forskning i HBM4. Disse nye standarder lover at levere hidtil usete datahastigheder, med HBM3E, der målretter mod hastigheder på op til 9,2 Gbps pr. pin og samlede båndbredder, der overstiger 1,2 TB/s pr. stak, et kritisk spring for AI-træning og inferens i stor skala (Samsung Electronics).

Disruptive grænsefladeteknologier er også ved at opstå for at tackle udfordringerne ved signalintegritet, strømlevering og termisk styring, der er iboende i at stable flere hukommelseschips og øge I/O-tætheden. Innovationer såsom avancerede gennem-silikon via (TSV) arkitekturer, forbedrede interposer-materialer og adoptionen af chiplet-baserede designs muliggør tættere integration mellem AI-acceleratorer og HBM-stakke. For eksempel udforskes brugen af silicium-broer og organiske interposere for at reducere omkostningerne og forbedre skalerbarheden, samtidig med at den høje hastighedssignalering, der kræves af næste gens HBM, opretholdes (Advanced Micro Devices, Inc.).

Set fremad vil integrationen af HBM med fremvoksende AI-acceleratorarkitekturer—såsom dem, der udnytter 2.5D og 3D pakning—yderligere udviske grænserne mellem hukommelse og beregning. Denne co-pakning tilgang forventes at minimere databevægelsen, reducere energiforbruget og åbne nye niveauer af parallelisme for store sprogmodeller og generative AI-arbejdsbelastninger. Branchen ledere samarbejder også om nye interfaceprotokoller og fejlkorrigeringsordninger for at sikre pålidelighed og skalerbarhed, efterhånden som hukommelsesbåndbredderne stiger (Micron Technology, Inc.).

Sammenfattende vil fremtiden for HBM-interface design til AI-acceleratorer blive formet af hurtige fremskridt i hukommelsesteknologi, pakningsinnovation og systemniveau co-design. Disse udviklinger er indstillet til at redefinere præstationsgrænsen for AI-hardware i 2025 og fremover, og muliggør den næste bølge af gennembrud inden for maskinlæring og dataanalyse.

Strategiske anbefalinger til interessenter

Efterhånden som AI-acceleratorer i stigende grad er afhængige af høj-båndbredde hukommelse (HBM) for at imødekomme kravene fra storstilet maskinlæring og dyb læringsarbejdsbelastninger, skal interessenter—including chipdesignere, systemintegratorer og datacenteroperatører—adoptere fremadskuende strategier til at optimere HBM interface design. Følgende anbefalinger er skræddersyet til at adressere det udviklende landskab af HBM-integration i AI-hardware for 2025 og fremover.

- Prioriter co-design af hukommelse og beregning: Samarbejdende udvikling mellem hukommelses- og beregningsteams er essentiel. Ved at co-optimere HBM-grænsefladen med AI-acceleratorens arkitektur kan interessenter minimere latenstid og maksimere throughput. Virksomheder som Samsung Electronics Co., Ltd. og Micron Technology, Inc. har vist fordelene ved sådanne integrerede tilgange i deres nyeste HBM-løsninger.

- Adoptér de nyeste HBM-standarder: At holde sig ajour med de nyeste HBM-standarder, såsom HBM3 og den kommende HBM4, sikrer kompatibilitet og adgang til højere båndbredder og forbedret energieffektivitet. JEDEC Solid State Technology Association opdaterer regelmæssigt disse standarder, og tidlig adoption kan give en konkurrencefordel.

- Invester i avancerede pakningsteknologier: 2.5D og 3D integration, såsom siliciuminterposere og gennem-silikon vias (TSVs), er kritiske for effektiv HBM-interface design. Samarbejde med pakningsspecialister som Taiwan Semiconductor Manufacturing Company Limited (TSMC) kan hjælpe interessenter med at udnytte cutting-edge interconnect-løsninger.

- Optimer strømlevering og termisk styring: Efterhånden som HBM-stakke vokser i tæthed og hastighed, bliver strømlevering og varmeafledning mere udfordrende. Interessenter bør investere i avancerede styrings-IC’er og innovative køleløsninger i samarbejde med partnere som CoolIT Systems Inc. til termisk styring.

- Fremme økosystem samarbejde: At engagere sig med branchekonsortier og standardiseringsorganer, såsom OIF (Optical Internetworking Forum), kan hjælpe interessenter med at holde sig informeret om grænseflade-innovationer og interoperabilitetskrav.

Ved at implementere disse strategiske anbefalinger kan interessenter sikre, at deres HBM-interface design til AI-acceleratorer forbliver robuste, skalerbare og fremtidssikrede, hvilket understøtter den næste generation af AI-arbejdsbelastninger.

Kilder & Referencer

- Micron Technology, Inc.

- NVIDIA Corporation

- JEDEC Solid State Technology Association

- Amkor Technology, Inc.

- Cray Inc.

- Fujitsu Limited

- Synopsys, Inc.

- OIF (Optical Internetworking Forum)