Ξεκλειδώνοντας τη δύναμη της μνήμης υψηλού εύρους ζώνης: Πώς ο σχεδιασμός της διεπαφής HBM επαναστατεί στους επιταχυντές AI το 2025 και Beyond. Εξερευνήστε τις τεχνολογίες, την ανάπτυξη της αγοράς και τις στρατηγικές ευκαιρίες που διαμορφώνουν την επόμενη εποχή του υλικού AI.

- Εκτενής Περίληψη: Βασικά ευρήματα και στρατηγικές επιγνώσεις

- Επισκόπηση Αγοράς: Σχεδιασμός Διεπαφής HBM για Επιταχυντές AI το 2025

- Τεχνολογικό Τοπίο: Εξέλιξη των Προτύπων και Αρχιτεκτονικών HBM

- Ανάλυση Ανταγωνισμού: Οι Κύριοι Παίκτες και οι Τάσεις Καινοτομίας

- Μέγεθος και Πρόβλεψη Αγοράς (2025–2030): CAGR, Προβλέψεις Εσόδων και Περιφερειακή Κατανομή

- Κίνητρα και Προκλήσεις: Απαιτήσεις Απόδοσης, Ενεργειακή Απόδοση και Πολυπλοκότητες Ενοποίησης

- Αναδυόμενες Εφαρμογές: AI, HPC, Κέντρα Δεδομένων και Υπολογιστική Edge

- Ανάλυση Εφοδιαστικής Αλυσίδας και Οικοσυστήματος

- Μέλλον: Διαταρακτικές Τεχνολογίες και Διεπαφές HBM Νέας Γενιάς

- Στρατηγικές Συστάσεις για τους Ενδιαφερόμενους

- Πηγές & Αναφορές

Εκτενής Περίληψη: Βασικά ευρήματα και στρατηγικές επιγνώσεις

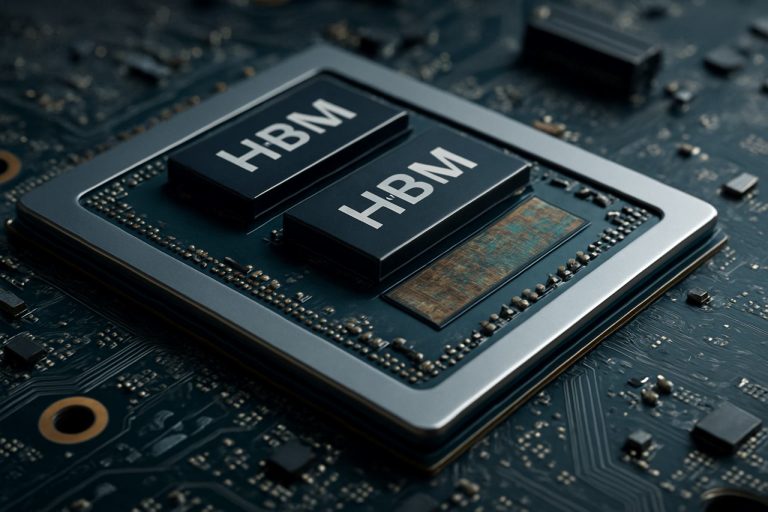

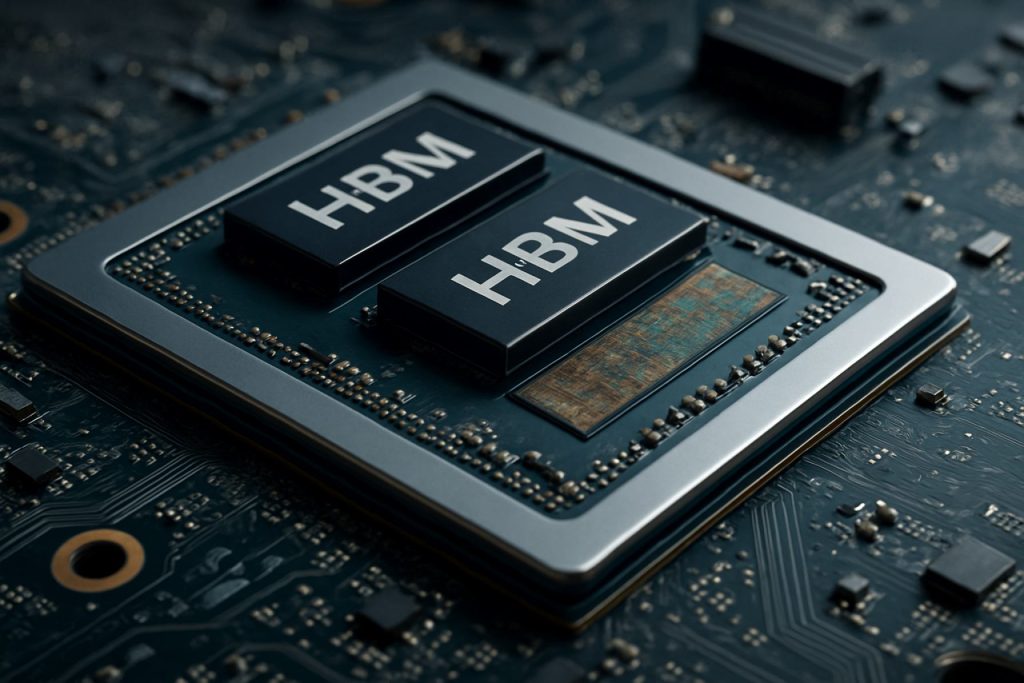

Ο σχεδιασμός της διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) έχει αναδειχθεί σε κρίσιμο παράγοντα ενεργοποίησης για τους επιταχυντές AI επόμενης γενιάς, αντιμετωπίζοντας τις αυξανόμενες απαιτήσεις για εύρος ζώνης μνήμης, ενεργειακή απόδοση και συμπαγείς μορφές στις εφαρμογές που απαιτούν δεδομένα. Το 2025, η ταχεία εξέλιξη των φόρτων εργασία AI—ιδιαίτερα στη βαθιά μάθηση και τα μεγάλα γλωσσικά μοντέλα—έχει εντείνει την ανάγκη για λύσεις μνήμης που μπορούν να παρέχουν τερα bytes ανά δευτερόλεπτο εύρους ζώνης, μειώνοντας παράλληλα τη καθυστέρηση και την ενεργειακή κατανάλωση. Η HBM, με την αρχιτεκτονική 3D stacking και την τεχνολογία μέσω σιλικονίων αγωγών (TSV), έχει γίνει η προτιμώμενη μνήμη για τους ηγέτες των επιταχυντών AI.

Τα βασικά ευρήματα δείχνουν ότι η υιοθέτηση του HBM3 και η αναμενόμενη κυκλοφορία του HBM4 θέτουν νέα πρότυπα στην εύρος ζώνης, με το HBM3 να προσφέρει έως 819 GB/s ανά στοίβα και το HBM4 να αναμένεται ότι θα υπερβεί το 1 TB/s. Αυτές οι εξελίξεις επιτρέπουν στους επιταχυντές AI να επεξεργάζονται μεγαλύτερα επιμέρους σύνολα δεδομένων σε πραγματικό χρόνο, βελτιώνοντας σημαντικά την απόδοση εκπαίδευσης και συμπερασμού. Μεγάλοι παίκτες της βιομηχανίας όπως η Samsung Electronics Co., Ltd., Micron Technology, Inc., και η SK hynix Inc. είναι στην πρωτοπορία της καινοτομίας HBM, συνεργαζόμενοι στενά με σχεδιαστές υλικού AI για τη βελτιστοποίηση των πρωτοκόλλων διεπαφής και της ακεραιότητας σήματος.

Οι στρατηγικές επιγνώσεις αποκαλύπτουν ότι ο επιτυχής σχεδιασμός διεπαφής HBM εξαρτάται από αρκετούς παράγοντες: προηγμένες τεχνικές συσκευασίας (όπως η 2.5D και η 3D ενοποίηση), ισχυρή διαχείριση θερμότητας και ο συν-σχεδιασμός των ελεγκτών μνήμης με τους πυρήνες επεξεργασίας AI. Εταιρείες όπως η Advanced Micro Devices, Inc. και η NVIDIA Corporation αξιοποιούν αυτές τις στρατηγικές για να προσφέρουν επιταχυντές AI με πρωτοφανείς μετρήσεις απόδοσης ανά watt. Επιπλέον, η ενοποίηση της HBM με αρχιτεκτονικές chiplet κερδίζει έδαφος, προσφέροντας αρθρωτότητα και κλίμακα για μελλοντικά συστήματα AI.

Ατενίζοντας το μέλλον, το οικοσύστημα διεπαφών HBM αναμένεται να επωφεληθεί από τις προσπάθειες τυποποίησης που ηγούνται οργανώσεις όπως η JEDEC Solid State Technology Association, οι οποίες απλουστεύουν τη διαλειτουργικότητα και επιταχύνουν το χρόνο εισαγωγής στην αγορά νέων λύσεων μνήμης. Καθώς τα μοντέλα AI συνεχίζουν να γίνονται πιο πολύπλοκα, η στρατηγική ευθυγράμμιση του σχεδιασμού της διεπαφής HBM με τις εξελισσόμενες φόρτους εργασίας AI θα είναι κρίσιμη για τη διατήρηση του ανταγωνιστικού πλεονεκτήματος στο τοπίο του υλικού AI.

Επισκόπηση Αγοράς: Σχεδιασμός Διεπαφής HBM για Επιταχυντές AI το 2025

Η αγορά για το σχεδιασμό διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) στους επιταχυντές AI είναι έτοιμη για σημαντική ανάπτυξη το 2025, υποκινούμενη από τις αυξανόμενες υπολογιστικές απαιτήσεις των εργασιών τεχνητής νοημοσύνης και μηχανικής μάθησης. Η HBM, μια τεχνολογία DRAM 3D-stacked, προσφέρει σημαντικές βελτιώσεις στην εύρος ζώνης μνήμης και την ενεργειακή απόδοση σε σύγκριση με παραδοσιακές λύσεις μνήμης, καθιστώντας την κρίσιμο παράγοντα ενεργοποίησης για τους επιταχυντές AI επόμενης γενιάς.

Το 2025, η υιοθέτηση διεπαφών HBM επιταχύνεται από τις κορυφαίες ημιαγωγικές εταιρείες και τους φορείς κέντρων δεδομένων υποκλίμακας που επιδιώκουν να ξεπεράσουν τα προβλήματα μνήμης που εγγενώς υπάρχουν στις εργασίες εκπαίδευσης και συμπερασμού AI. Τα πιο πρόσφατα πρότυπα HBM, όπως το HBM3 και το αναδυόμενο HBM3E, παρέχουν εύρος ζώνης που ξεπερνά το 1 TB/s ανά συσκευή, υποστηρίζοντας τις απαιτήσεις παράλληλης επεξεργασίας των μεγάλων γλωσσικών μοντέλων και των συστημάτων γενετικής AI. Εταιρείες όπως η Samsung Electronics Co., Ltd., Micron Technology, Inc., και η SK hynix Inc. είναι στην πρωτοπορία της ανάπτυξης HBM, προσφέροντας λύσεις μνήμης που ενσωματώνονται γρήγορα στους σχεδιασμούς επιταχυντών AI.

Ο σχεδιασμός διεπαφής για την HBM στους επιταχυντές AI είναι συνεχώς πιο περίπλοκος, απαιτώντας προηγμένες τεχνολογίες συσκευασίας όπως η ολοκλήρωση 2.5D και 3D. Αυτές οι προσεγγίσεις επιτρέπουν την κοντινή φυσική εγγύτητα των στοίβων HBM στις μονάδες επεξεργασίας, ελαχιστοποιώντας τη καθυστέρηση και μεγιστοποιώντας την απόδοση δεδομένων. Οι βιομηχανίες κατασκευής ημιαγωγών όπως η Taiwan Semiconductor Manufacturing Company Limited (TSMC) και η Intel Corporation επενδύουν σε προηγμένες λύσεις μετώπου και συσκευασίας για να υποστηρίξουν αυτές τις αρχιτεκτονικές.

Η ζήτηση για επιταχυντές AI που υποστηρίζουν HBM είναι ιδιαίτερα ισχυρή στους τομείς των κέντρων δεδομένων cloud, υπολογιστικής edge, και υψηλής απόδοσης υπολογισμού (HPC). Οι κύριοι προμηθευτές τσιπ AI, συμπεριλαμβανομένων των NVIDIA Corporation και Advanced Micro Devices, Inc. (AMD), ενσωματώνουν HBM στα προϊόντα τους να παρέχουν την απαραίτητη εύρος ζώνης μνήμης για τα πιο σύγχρονα μοντέλα AI. Το ανταγωνιστικό τοπίο διαμορφώνεται περαιτέρω από τις εξελισσόμενες προδιαγραφές από οργανώσεις όπως η JEDEC Solid State Technology Association, οι οποίες συνεχίζουν να ορίζουν νέες προδιαγραφές HBM για να ανταποκριθούν στις μελλοντικές απαιτήσεις AI.

Συνολικά, η αγορά σχεδίασης διεπαφής HBM για επιταχυντές AI το 2025 χαρακτηρίζεται από ταχεία καινοτομία, στρατηγικές συνεργασίες σε όλη την αλυσίδα εφοδιασμού ημιαγωγών, και αδιάκοπη εστίαση στην εύρος ζώνης, την ενεργειακή απόδοση και την κλίμακα για να υποστηρίξουν το επόμενο κύμα εξελίξεων AI.

Τεχνολογικό Τοπίο: Εξέλιξη των Προτύπων και Αρχιτεκτονικών HBM

Το τεχνολογικό τοπίο για το σχεδιασμό της διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) έχει εξελιχθεί ταχύτατα για να καλύψει τις αυξανόμενες απαιτήσεις των επιταχυντών AI. Από την εισαγωγή της, η HBM έχει υποστεί αρκετές γενεακές βελτιώσεις, κάθε επανάληψη παρέχοντας υψηλότερη εύρος ζώνης, αυξημένη χωρητικότητα και βελτιωμένη ενεργειακή απόδοση. Το αρχικό πρότυπο HBM, που αναπτύχθηκε από την Samsung Electronics Co., Ltd. και τη SK hynix Inc. σε συνεργασία με την Advanced Micro Devices, Inc. (AMD), έθεσε τα θεμέλια για την υ stacking των τσιπ DRAM κάθετα και τη σύνδεσή τους με μέσω σιλικονίων αγωγών (TSVs), επιτρέποντας ευρεία είσοδο/έξοδο και χαμηλή κατανάλωση ισχύος.

Τα πρότυπα HBM2 και HBM2E, που εγκρίθηκαν από την JEDEC Solid State Technology Association, αύξησαν περαιτέρω την εύρος ζώνης ανά στοίβα και τη χωρητικότητα, υποστηρίζοντας έως και 3.6 Gbps ανά ακίδα και 16 GB ανά στοίβα. Αυτές οι βελτιώσεις ήταν κρίσιμες για τους επιταχυντές AI, οι οποίοι απαιτούν γρήγορη πρόσβαση σε μεγάλα σύνολα δεδομένων και μοντέλα. Το πιο πρόσφατο πρότυπο HBM3, που εισήχθη το 2022, ωθεί την εύρος ζώνης σε πάνω από 6.4 Gbps ανά ακίδα και χωρητικότητες έως 24 GB, με την Micron Technology, Inc. και τη SK hynix Inc. να είναι ανάμεσα στους πρώτους που ανακοίνωσαν προϊόντα HBM3. Το HBM3E, το οποίο αναμένεται να υιοθετηθεί ευρέως το 2025, προβλέπεται να προσφέρει ακόμα υψηλότερες ταχύτητες και βελτιωμένη διαχείριση θερμότητας, καλύπτοντας τις ανάγκες των φορτίων εργασίας AI επόμενης γενιάς.

Αρχιτεκτονικά, η ενσωμάτωση της HBM με τους επιταχυντές AI έχει μεταβληθεί από την παραδοσιακή τοποθέτηση PCB πλευρά-με-πλευρά σε 2.5D και 3D συσκευασία, όπως οι σιλικόνες διαμεσολαβητές και οι προηγμένες σχεδιάσεις chiplet. Η NVIDIA Corporation και η AMD έχουν πρωτοστατήσει στη χρήση HBM στα GPUs και στους επιταχυντές AI τους, χρησιμοποιώντας αυτές τις τεχνικές συσκευασίας για να ελαχιστοποιούν την απώλεια σήματος και να μεγιστοποιούν την εύρος ζώνης μνήμης. Η υιοθέτηση οπτικών που είναι πακέτο και ελεγκτών μνήμης που είναι ενσωματωμένοι στο τσιπ αναδύεται επίσης, μειώνοντας περαιτέρω τη διάρκεια καθυστέρησης και την ενεργειακή κατανάλωση.

Ατενίζοντας το 2025, το τοπίο σχεδιασμού διεπαφής HBM χαρακτηρίζεται από μια εστίαση στην κλίμακα, την ενεργειακή απόδοση και την ευελιξία ενσωμάτωσης. Οι ηγέτες της βιομηχανίας συνεργάζονται σε νέα πρότυπα και αναφορές αρχιτεκτονικών για να διασφαλίσουν τη διαλειτουργικότητα και να υποστηρίξουν την εκθετική ανάπτυξη του μεγέθους και της πολυπλοκότητας των μοντέλων AI. Καθώς οι επιταχυντές AI συνεχίζουν να επεκτείνουν τα όρια της απόδοσης, η εξέλιξη των προτύπων και των αρχιτεκτονικών HBM παραμένει θεμέλιος λίθος της καινοτομίας στο πεδίο.

Ανάλυση Ανταγωνισμού: Οι Κύριοι Παίκτες και οι Τάσεις Καινοτομίας

Το ανταγωνιστικό τοπίο για το σχεδιασμό διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) στους επιταχυντές AI εξελίσσεται ταχύτατα, υποκινούμενο από τις αυξανόμενες απαιτήσεις των φορτίων εργασίας τεχνητής νοημοσύνης και την ανάγκη για αποδοτική και ταχεία μεταφορά δεδομένων μεταξύ μνήμης και μονάδων επεξεργασίας. Κύριοι παίκτες της βιομηχανίας όπως η Samsung Electronics Co., Ltd., Micron Technology, Inc., και η SK hynix Inc. κυριαρχούν στο τομέα παραγωγής HBM, εισάγοντας καθένας τις διαδοχικές γενιές του HBM (HBM2E, HBM3 και πέρα) με αυξημένη εύρος ζώνης, χωρητικότητα και ενεργειακή απόδοση.

Στον τομέα των επιταχυντών AI, εταιρείες όπως η NVIDIA Corporation και η Advanced Micro Devices, Inc. (AMD) έχουν ενσωματώσει HBM στα κορυφαία GPUs και στους επιταχυντές κέντρων δεδομένων τους, αξιοποιώντας τη ευρεία διεπαφή της μνήμης και τη 3D συσκευασία για να ελαχιστοποιούν τους περιορισμούς στη βαθιά μάθηση και τις εφαρμογές υψηλής απόδοσης υπολογισμού. Η Intel Corporation έχει επίσης υιοθετήσει την HBM στα προϊόντα AI και HPC της, εστιάζοντας στη βελτιστοποίηση της διεπαφής για χαμηλότερη καθυστέρηση και υψηλότερη απόδοση.

Οι τάσεις καινοτομίας στο σχεδιασμό διεπαφής HBM επικεντρώνονται στη μεγιστοποίηση της εύρος ζώνης ενώ μειώνουν την κατανάλωση ενέργειας και τη φυσική επιφάνεια. Τεχνικές όπως προηγμένες αρχιτεκτονικές μέσω σιλικονίων διαδρομών (TSV), βελτιωμένη ακεραιότητα σήματος και δυναμική ρύθμιση τάσης/συχνότητας εφαρμόζονται για να αντιμετωπίσουν αυτές τις προκλήσεις. Η υιοθέτηση του HBM3 και η ανάπτυξη προτύπων HBM4, με ηγέτη τη JEDEC Solid State Technology Association, προωθούν τα όρια της εύρος ζώνης μνήμης, με το HBM3 να στοχεύει ταχύτητες που ξεπερνούν τα 800 GB/s ανά στοίβα και το HBM4 να αναμένεται ότι θα το υπερβεί σημαντικά.

Μια άλλη αξιοσημείωτη τάση είναι η συν-συσκευασία HBM με τους επιταχυντές AI χρησιμοποιώντας προηγμένες τεχνολογίες συσκευασίας όπως η 2.5D και η 3D ενοποίηση. Η Taiwan Semiconductor Manufacturing Company Limited (TSMC) και η Amkor Technology, Inc. είναι στην πρωτοπορία της παροχής αυτών των λύσεων συσκευασίας, επιτρέποντας στενότερη ενσωμάτωσή τους και βελτιωμένη διαχείριση θερμότητας. Αυτή η προσέγγιση συν-σχεδιασμού είναι κρίσιμη για τα συστήματα AI επόμενης γενιάς, όπου η εύρος ζώνης μνήμης και η εγγύτητα στις μονάδες υπολογισμού επηρεάζουν άμεσα την απόδοση και την αποδοτικότητα.

Συνοψίζοντας, οι ανταγωνιστικές δυναμικές στο σχεδιασμό διεπαφής HBM για επιταχυντές AI διαμορφώνονται από ταχεία καινοτομία, στρατηγικές συνεργασίες μεταξύ κατασκευαστών μνήμης και τσιπ, καθώς και την αδιάκοπη αναζήτηση υψηλότερης εύρους ζώνης και πιο αποδοτικών λύσεων ενέργειας για να καλύψουν τις ανάγκες των φορτίων εργασίας που κινεί η AI.

Μέγεθος και Πρόβλεψη Αγοράς (2025–2030): CAGR, Προβλέψεις Εσόδων και Περιφερειακή Κατανομή

Η αγορά για το σχεδιασμό διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) στους επιταχυντές AI είναι έτοιμη για ισχυρή ανάπτυξη μεταξύ 2025 και 2030, υποκινούμενη από την αυξανόμενη ζήτηση για υπολογιστική υψηλής απόδοσης στην τεχνητή νοημοσύνη, τη μηχανική μάθηση και τις εφαρμογές κέντρων δεδομένων. Η παγκόσμια αγορά διεπαφής HBM προβλέπεται να καταγράψει ετήσιο συντελεστή ανάπτυξης (CAGR) περίπου 25–30% κατά τη διάρκεια αυτής της περιόδου, αντικατοπτρίζοντας την ταχεία υιοθέτηση επιταχυντών AI που υποστηρίζουν HBM σε περιβάλλοντα επιχείρησης και cloud.

Οι προβλέψεις εσόδων δείχνουν ότι το μέγεθος της αγοράς, που εκτιμάται σε $2.5 δισεκατομμύρια το 2025, θα μπορούσε να υπερβεί τα $7.5 δισεκατομμύρια μέχρι το 2030. Αυτή η αύξηση αποδίδεται στη συνεχώς αυξανόμενη ενσωμάτωση της HBM στους τσιπ AI επόμενης γενιάς, οι οποίοι απαιτούν υπερταχείες διεπαφές μνήμης για να χειριστούν τεράστια φόρτια παράλληλης επεξεργασίας. Σημαντικοί παίκτες της βιομηχανίας, όπως η Samsung Electronics Co., Ltd., Micron Technology, Inc., και η SK hynix Inc. επενδύουν σημαντικά στην έρευνα και ανάπτυξη για την πρόοδο των τεχνολογιών διεπαφής HBM, επιταχύνοντας περαιτέρω την επέκταση της αγοράς.

Περιφερειακά, η Ασία-Ειρηνικός αναμένεται να κυριαρχήσει στην αγορά σχεδιασμού διεπαφής HBM, αντιπροσωπεύοντας πάνω από το 45% των παγκόσμιων εσόδων μέχρι το 2030. Αυτή η κυριαρχία στηρίζεται στην παρουσία σημαντικών κατασκευαστών ημιαγωγών και κατασκευαστών μνήμης σε χώρες όπως η Νότια Κορέα, η Ταϊβάν και η Κίνα. Η Βόρεια Αμερική ακολουθεί στενά, υποκινούμενη από την συγκέντρωση των κατασκευαστών επιταχυντών AI και των υποκλίμακας κέντρων δεδομένων στις Ηνωμένες Πολιτείες και τον Καναδά. Η Ευρώπη επίσης παρατηρεί σταθερή ανάπτυξη, ιδιαίτερα στους τομείς AI αυτοκινήτου και αυτοματοποίησης βιομηχανίας.

Η πληθώρα εφαρμογών που κινεί η AI στην υπολογιστική edge, τα αυτόνομα οχήματα και το υψηλής συχνότητας εμπόριο επιταχύνει περαιτέρω την υιοθέτηση προηγμένων διεπαφών HBM. Καθώς τα μοντέλα AI γίνονται πιο περίπλοκα και απαιτητικά σε δεδομένα, η ανάγκη για υψηλότερη εύρος ζώνης μνήμης και χαμηλότερη καθυστέρηση ωθεί τους σχεδιαστές τσιπ να υιοθετούν τα πρότυπα HBM2E, HBM3 και τα αναδυόμενα HBM4, όπως ορίζονται από την JEDEC Solid State Technology Association.

Συνοψίζοντας, η αγορά σχεδιασμού διεπαφής HBM για επιταχυντές AI είναι έτοιμη για σημαντική επέκταση μέχρι το 2030, με ισχυρή περιφερειακή ανάπτυξη στην Ασία-Ειρηνικό και την Βόρεια Αμερική, και μια σαφή τάση προς υψηλότερη εύρος ζώνης και πιο ενεργειακά αποδοτικές λύσεις μνήμης.

Κίνητρα και Προκλήσεις: Απαιτήσεις Απόδοσης, Ενεργειακή Απόδοση και Πολυπλοκότητες Ενοποίησης

Η ταχεία εξέλιξη των φορτίων εργασίας τεχνητής νοημοσύνης (AI) έχει θέσει πρωτοφανείς απαιτήσεις στα υποσυστήματα μνήμης, καθιστώντας τη μνήμη υψηλού εύρους ζώνης (HBM) έναν κρίσιμο ενεργοποιητή για τους επιταχυντές AI επόμενης γενιάς. Ο σχεδιασμός των διεπαφών HBM πρέπει να αντιμετωπίσει αρκετές κύριες κινητήριες δυνάμεις και προκλήσεις, ιδιαίτερα στους τομείς της απόδοσης, της ενεργειακής απόδοσης και της πολυπλοκότητας ενσωμάτωσης.

Απαιτήσεις Απόδοσης: Οι επιταχυντές AI απαιτούν τεράστια εύρος ζώνης μνήμης για να τροφοδοτήσουν μηχανές υπολογισμού που καταναλώνουν δεδομένα, ειδικά για μοντέλα βαθιάς μάθησης με δισεκατομμύρια παραμέτρους. Η HBM, με την αρχιτεκτονική 3D stacking και την ευρεία είσοδο/έξοδο, προσφέρει εύρος ζώνης που ξεπερνά το 1 TB/s στις πιο πρόσφατες γενιές. Ωστόσο, η επίτευξη αυτού στην πράξη απαιτεί προσεκτικό σχεδιασμό διεπαφής για να ελαχιστοποιηθούν οι καθυστερήσεις, να μεγιστοποιηθεί η απόδοση και να διασφαλιστεί η ακεραιότητα σήματος σε υψηλές ταχύτητες δεδομένων. Η διεπαφή πρέπει επίσης να υποστηρίζει αποτελεσματικά μοτίβα μετακίνησης δεδομένων τυπικά για φορτία εργασίας AI, όπως μεγάλες πολλαπλασιασμούς μητρών και τεχνικές τεντώματος, οι οποίες επιβαρύνουν περαιτέρω τους ελεγκτές μνήμης και τους διασυνδέσμους.

Ενεργειακή Απόδοση: Καθώς οι επιταχυντές AI κλιμακώνονται, η κατανάλωση ενέργειας γίνεται ένας κρίσιμος περιορισμός, τόσο για τις αναπτύξεις κέντρων δεδομένων όσο και για τις εφαρμογές edge. Η εγγύτητα της HBM στον επεξεργαστή και η χρήση σιλικονίων αγωγών (TSVs) μειώνουν την ενέργεια ανά bit σε σύγκριση με τη παραδοσιακή μνήμη DDR. Παρόλα αυτά, ο σχεδιασμός της διεπαφής πρέπει να βελτιώσει περαιτέρω την ενέργεια μέσω προηγμένων τεχνικών σήμανσης, δυναμικής ρύθμισης τάσης και συχνότητας, και έξυπνης διαχείρισης ενέργειας. Η ισορροπία μεταξύ υψηλής εύρους ζώνης και χαμηλής κατανάλωσης ενέργειας είναι μια διαρκής πρόκληση, ειδικά καθώς οι στοίβες μνήμης αυξάνονται σε χωρητικότητα και ταχύτητα. Οργανισμοί όπως η Samsung Electronics Co., Ltd. και η Micron Technology, Inc. αναπτύσσουν ενεργά νέες γενιές HBM με βελτιωμένη ενεργειακή αποδοτικότητα.

Πολυπλοκότητες Ενοποίησης: Η ενσωμάτωση της HBM με επιταχυντές AI περιλαμβάνει σημαντικές προκλήσεις συσκευασίας και συστημάτων. Η φυσική στοίβαξη μνημονικών τσιπ και η σύνδεσή τους στον επεξεργαστή μέσω σιλικονίων αγωγών ή προηγμένων υποστρωμάτων απαιτούν ακριβή κατασκευή και διαχείριση θερμότητας. Η ακεραιότητα σήματος, η ηλεκτρομαγνητική παρεμβολή και η μηχανική πίεση πρέπει να αντιμετωπιστούν για να διασφαλιστεί η αξιόπιστη λειτουργία. Επιπλέον, η διεπαφή πρέπει να είναι συμβατή με τις εξελισσόμενες προδιαγραφές, όπως αυτές που ορίζονται από την JEDEC Solid State Technology Association, για να διασφαλίσει τη διαλειτουργικότητα και την μελλοντική κλιμάκωση. Η πολυπλοκότητα αυξάνεται καθώς οι επιταχυντές υιοθετούν αρχιτεκτονικές chiplet, απαιτώντας ισχυρές λύσεις διεπαφής HBM που να μπορούν να υποστηρίξουν την ετερογενή ενσωμάτωση.

Συνοψίζοντας, ο σχεδιασμός διεπαφών HBM για τους επιταχυντές AI το 2025 διαμορφώνεται από την ανάγκη να παραδοθούν εξαιρετική εύρος ζώνης, να διατηρηθεί η ενεργειακή απόδοση και να διαχειριστούν οι πολυπλοκότητες της προηγμένης ενσωμάτωσης, ενώ παράλληλα ακολουθούν την ταχεία καινοτομία στον τομέα του υλικού AI.

Αναδυόμενες Εφαρμογές: AI, HPC, Κέντρα Δεδομένων και Υπολογιστική Edge

Η ταχεία εξέλιξη των τεχνητής νοημοσύνης (AI), του υψηλής απόδοσης υπολογισμού (HPC), των κέντρων δεδομένων και της υπολογιστικής edge προωθεί πρωτοφανή ζήτηση για εύρος ζώνης και αποδοτικότητα μνήμης. Ο σχεδιασμός διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) έχει γίνει μια βασική τεχνολογία για τους επιταχυντές AI, επιτρέποντας τη μαζική παραλληλία και τη μεταφορά δεδομένων που απαιτείται από σύγχρονα φορτία εργασίας βαθιάς μάθησης και ανάλυσης. Η HBM επιτυγχάνει αυτό μέσω της στοίβαξης πολλών τσιπ DRAM κάθετα και της σύνδεσής τους μέσω σιλικονίων αγωγών (TSVs), οδηγώντας σε σημαντικά υψηλότερη εύρος ζώνης και χαμηλότερη κατανάλωση ενέργειας σε σύγκριση με τις παραδοσιακές διεπαφές μνήμης.

Στους επιταχυντές AI, όπως αυτοί που αναπτύσσονται από την NVIDIA Corporation και την Advanced Micro Devices, Inc. (AMD), οι διεπαφές HBM είναι κρίσιμες για την τροφοδοσία δεδομένων σε χιλιάδες πυρήνες επεξεργασίας χωρίς περιορισμούς. Τα πιο πρόσφατα πρότυπα HBM3 και HBM3E, όπως ορίζονται από την JEDEC Solid State Technology Association, υποστηρίζουν εύρος ζώνης που ξεπερνά το 1 TB/s ανά στοίβα, το οποίο είναι ουσιαστικό για την εκπαίδευση μεγάλων νευρωνικών δικτύων και της πραγματικής αναγνώρισης σε κέντρα δεδομένων. Αυτές οι διεπαφές είναι στενά ενσωματωμένες με την επιταχυντική δία μέσω προηγμένων τεχνικών συσκευασίας όπως η 2.5D και η 3D ενοποίηση, ελαχιστοποιώντας την απώλεια σήματος και τις καθυστερήσεις.

Σε περιβάλλοντα HPC, η υψηλή μνήμη HBM και η ενεργειακή απόδοσή της αξιοποιούνται για την επιτάχυνση επιστημονικών προσομοιώσεων, χρηματοοικονομικής μοντελοποίησης και άλλων απαιτητικών δεδομένων εργασιών. Σупερυπουνητές όπως εκείνοι που δημιούργησε η Cray Inc. και η Fujitsu Limited χρησιμοποιούν HBM-ενεργοποιημένες επεξεργαστές για να επιτύχουν στόχους απόδοσης στα petascale και exascale. Ο σχεδιασμός διεπαφής πρέπει να αντιμετωπίζει προκλήσεις όπως η ακεραιότητα σήματος, η διαχείριση θερμότητας και η διόρθωση σφαλμάτων για να διασφαλιστεί η αξιόπιστη λειτουργία υπό ακραία φορτία εργασίας.

Συσκευές υπολογιστικής edge, οι οποίες απαιτούν συμπαγείς μορφές και χαμηλή κατανάλωση ενέργειας, αρχίζουν επίσης να υιοθετούν διεπαφές HBM. Εταιρείες όπως η Samsung Electronics Co., Ltd. και η SK hynix Inc. αναπτύσσουν λύσεις HBM προσαρμοσμένες για τσιπ AI edge, ισορροπώντας τις ανάγκες εύρους ζώνης με αυστηρούς περιορισμούς σε ενέργεια και θερμότητα.

Ατενίζοντας το 2025, η συνεχής βελτίωση του σχεδιασμού διεπαφής HBM θα είναι καίριας σημασίας για την υποστήριξη της επόμενης γενιάς AI, HPC και edge εφαρμογών. Καινοτομίες στις συσκευασίες, την σήμανση και τις αρχιτεκτονικές ελεγκτών μνήμης θα βελτιώσουν περαιτέρω την κλίμακα και την αποδοτικότητα των επιταχυντών AI, διασφαλίζοντας ότι η εύρος ζώνης μνήμης παραμένει συμβατή με την εκθετική ανάπτυξη στην υπολογιστική ζήτηση.

Ανάλυση Εφοδιαστικής Αλυσίδας και Οικοσυστήματος

Η εφοδιαστική αλυσίδα και το οικοσύστημα για το σχεδιασμό διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) στους επιταχυντές AI χαρακτηρίζονται από ένα σύνθετο δίκτυο κατασκευαστών ημιαγωγών, προμηθευτών μνήμης, εργοστασίων και παρόχων εργαλείων σχεδίασης. Η HBM, με τα κάθετα στοιβαγμένα τσιπ DRAM και τη ευρεία διεπαφή, είναι ένας κρίσιμος ενεργοποιητής για τους επιταχυντές AI, προσφέροντας την εύρος ζώνης και την ενεργειακή απόδοση που απαιτείται για μεγάλης κλίμακας εργασίες μηχανικής μάθησης. Ο σχεδιασμός και η ενσωμάτωσή της διεπαφής HBM απαιτούν στενή συνεργασία μεταξύ προμηθευτών μνήμης, όπως η Samsung Electronics Co., Ltd., Micron Technology, Inc., και η SK hynix Inc., και κορυφαίων σχεδιαστών τσιπ AI όπως η NVIDIA Corporation και η Advanced Micro Devices, Inc. (AMD).

Το οικοσύστημα υποστηρίζεται επίσης από προηγμένες τεχνολογίες συσκευασίας και διασύνδεσης, όπως οι σιλικόνες μεσολαβητές και οι 2.5D/3D ενοποιήσεις, που παρέχονται από εργοστάσια όπως η Taiwan Semiconductor Manufacturing Company Limited (TSMC) και η Intel Corporation. Αυτές οι εγκαταστάσεις επιτρέπουν τη φυσική ενσωμάτωση των στοίβων HBM με τις δίες λογικής, διασφαλίζοντας την ακεραιότητα σήματος και τη διαχείριση θερμότητας σε υψηλές ταχύτητες δεδομένων. Οι προμηθευτές εργαλείων EDA, συμπεριλαμβανομένων των Synopsys, Inc. και Cadence Design Systems, Inc., προσφέρουν εξειδικευμένες λύσεις IP και επαλήθευσης για να αντιμετωπίσουν τις αυστηρές απαιτήσεις χρονισμού, ενέργειας και αξιοπιστίας των διεπαφών HBM.

Οι προσπάθειες τυποποίησης, που ηγούνται οργανώσεις όπως η JEDEC Solid State Technology Association, παίζουν κεντρικό ρόλο στη διαμόρφωση προδιαγραφών διεπαφής HBM και στη διασφάλιση της διαλειτουργικότητας σε όλη την εφοδιαστική αλυσίδα. Η ταχεία εξέλιξη των προτύπων HBM (π.χ. HBM3, HBM3E) απαιτεί από τους συμμετέχοντες στο οικοσύστημα να ενημερώνουν συνεχώς τις ροές σχεδίασης και τις διαδικασίες παραγωγής τους. Επιπλέον, η αυξανόμενη ζήτηση για επιταχυντές AI στα κέντρα δεδομένων και τις συσκευές edge ωθεί επενδύσεις στην επέκταση χωρητικότητας και στην ανθεκτικότητα της εφοδιαστικής αλυσίδας, όπως φαίνεται από τις πρόσφατες ανακοινώσεις από μεγάλους προμηθευτές μνήμης και εργοστάσια.

Συνοψίζοντας, το οικοσύστημα σχεδιασμού διεπαφής HBM για επιταχυντές AI το 2025 χαρακτηρίζεται από βαθιές αλληλεξαρτήσεις μεταξύ προμηθευτών μνήμης, σχεδιαστών τσιπ, εργοστασίων, πωλητών EDA και οργανισμών τυποποίησης. Αυτό το συνεργατικό περιβάλλον είναι ουσιώδες για την παροχή των υψηλής απόδοσης και ενεργειακά αποδοτικών υποσυστημάτων μνήμης που φέρνουν την επόμενη γενιά φορτίων εργασίας AI.

Μέλλον: Διαταρακτικές Τεχνολογίες και Διεπαφές HBM Νέας Γενιάς

Το μέλλον του σχεδιασμού διεπαφής μνήμης υψηλού εύρους ζώνης (HBM) για τους επιταχυντές AI είναι έτοιμο για σημαντική μεταμόρφωση, καθοδηγούμενο από διαταρακτικές τεχνολογίες και την εξέλιξη των προτύπων HBM επόμενης γενιάς. Καθώς οι φορτίες εργασίας AI συνεχίζουν να απαιτούν υψηλότερη εύρος ζώνης μνήμης και χαμηλότερες καθυστερήσεις, η βιομηχανία κινείται πέρα από το HBM2E και το HBM3 menuju ακόμα πιο προηγμένες λύσεις όπως το HBM3E και πρώιμη έρευνα για το HBM4. Αυτά τα νέα πρότυπα υπόσχονται να προσφέρουν πρωτοφανείς ταχύτητες δεδομένων, με το HBM3E να στοχεύει ταχύτητες έως και 9.2 Gbps ανά ακίδα και συνολικές εύρος ζώνης που υπερβαίνουν το 1.2 TB/s ανά στοίβα, ένα κρίσιμο άλμα για την εκπαίδευση και τη συμπερασματολογία AI σε κλίμακα (Samsung Electronics).

Διαταρακτικές τεχνολογίες διεπαφής αναδύονται επίσης για να αντιμετωπίσουν τις προκλήσεις της ακεραιότητας σήματος, της παράδοσης ενέργειας και της διαχείρισης θερμότητας που σχετίζονται με την στοίβαξή περισσότερων μνημονικών τσιπ και την αύξηση της πυκνότητας I/O. Καινοτομίες όπως προηγμένες αρχιτεκτονικές μέσω σιλικονίων αγωγών (TSV), βελτιωμένα υλικά διαμεσολαβητών και η υιοθέτηση σχεδίων chiplet παρέχουν την ικανότητα πιο στενής ενσωμάτωσης μεταξύ των επιταχυντών AI και των στοίβων HBM. Για παράδειγμα, η χρήση σιλικόνων γέφυρες και οργανικών μεσολαβητών διερευνάται για να μειώσει το κόστος και να βελτιώσει την κλίμακα, διατηρώντας παράλληλα τη σήμανση υψηλής ταχύτητας που απαιτεί το HBM επόμενης γενιάς (Advanced Micro Devices, Inc.).

Ατενίζοντας στο μέλλον, η ενσωμάτωση της HBM με τις αναδυόμενες αρχιτεκτονικές επιταχυντών AI—όπως αυτές που εκμεταλλεύονται τη 2.5D και 3D συσκευασία—θα «θολώσει» περαιτέρω τις γραμμές μεταξύ μνήμης και υπολογισμού. Αυτή η προσέγγιση συν-συσκευασίας αναμένεται να ελαχιστοποιεί την κίνηση δεδομένων, να μειώνει την ενεργειακή κατανάλωση και να απελευθερώνει νέα επίπεδα παραλληλίας για μεγάλα γλωσσικά μοντέλα και εργασίες generative AI. Οι ηγέτες της βιομηχανίας συνεργάζονται επίσης σχετικά με νέα πρωτόκολλα διεπαφής και σχέδια διόρθωσης σφαλμάτων για να διασφαλίσουν την αξιοπιστία και την κλιμάκωση καθώς οι μνήμες εύρους ζώνης επαναστατούν (Micron Technology, Inc.).

Συνοψίζοντας, το μέλλον του σχεδιασμού διεπαφής HBM για επιταχυντές AI θα διαμορφωθεί από τις ταχείες εξελίξεις στην τεχνολογία μνήμης, τη καινοτομία στη συσκευασία και τον συν-σχεδιασμό σε επίπεδο συστήματος. Αυτές οι εξελίξεις είναι έτοιμες να επαναστατήσουν το πλαίσιο απόδοσης για το υλικό AI το 2025 και πέρα, επιτρέποντας την επόμενη κυματιστή επανάσταση στις μηχανές μάθησης και την ανάλυση δεδομένων.

Στρατηγικές Συστάσεις για τους Ενδιαφερόμενους

Καθώς οι επιταχυντές AI βασίζονται ολοένα και περισσότερο σε μνήμη υψηλού εύρους ζώνης (HBM) για να καλύψουν τις απαιτήσεις των μεγάλων επιγοργών μηχανικής μάθησης και βαθιάς μάθησης, οι ενδιαφερόμενοι—συμπεριλαμβανομένων των σχεδιαστών τσιπ, των συστηματικών ολοκληρωτών και των διαχειριστών κέντρων δεδομένων—πρέπει να υιοθετήσουν προορατικούς στρατηγικούς σχεδιασμούς για να βελτιστοποιήσουν το σχεδιασμό διεπαφής HBM. Οι παρακάτω συστάσεις είναι προσαρμοσμένες για να αντιμετωπίσουν το εξελισσόμενο τοπίο της HBM ενσωμάτωσης στο υλικό AI για το 2025 και πέρα.

- Προτεραιότητα Συνεργασίας Σχεδιασμού Μνήμης και Υπολογισμού: Η συνεργατική ανάπτυξη μεταξύ των ομάδων μνήμης και υπολογισμού είναι ουσιώδης. Με τον συν-βέλτιστο σχεδιασμό της διεπαφής HBM με την αρχιτεκτονική του επιταχυντή AI, οι ενδιαφερόμενοι μπορούν να ελαχιστοποιήσουν την καθυστέρηση και να μεγιστοποιήσουν την απόδοση. Εταιρείες όπως η Samsung Electronics Co., Ltd. και η Micron Technology, Inc. έχουν αποδείξει τα οφέλη τέτοιων ενσωματωμένων προσεγγίσεων στις τελευταίες λύσεις HBM τους.

- Υιοθέτηση των τελευταίων προτύπων HBM: Η παρακολούθηση των τελευταίων προτύπων HBM, όπως το HBM3 και το αναδυόμενο HBM4, διασφαλίζει συμβατότητα και πρόσβαση σε υψηλότερες εύρος ζώνης και βελτιωμένη ενεργειακή απόδοση. Η JEDEC Solid State Technology Association ενημερώνει τακτικά αυτά τα πρότυπα, και η πρώιμη υιοθέτηση μπορεί να παρέχει ανταγωνιστικό πλεονέκτημα.

- Επένδυση σε Προηγμένες Τεχνολογίες Συσκευασίας: Η 2.5D και 3D ενοποίηση, όπως οι σιλικόνες μεσολαβητές και οι μέσω σιλικονίων αγωγοί (TSVs), είναι κρίσιμες για τον αποτελεσματικό σχεδιασμό διεπαφής HBM. Η συνεργασία με ειδικούς στη συσκευασία όπως η Taiwan Semiconductor Manufacturing Company Limited (TSMC) μπορεί να βοηθήσει τους ενδιαφερόμενους να αξιοποιήσουν καινοτόμες λύσεις διασύνδεσης.

- Βελτιστοποίηση Παράδοσης Ενέργειας και Διαχείρισης Θερμότητας: Καθώς οι στοίβες HBM αυξάνονται σε πυκνότητα και ταχύτητα, η παράδοση ενέργειας και η διάχυση θερμότητας γίνονται πιο προκλητικές. Οι ενδιαφερόμενοι θα πρέπει να επενδύσουν σε προηγμένα τσιπ διαχείρισης ενέργειας και καινοτόμες λύσεις ψύξης, συνεργαζόμενοι με συνεργάτες όπως η CoolIT Systems Inc. για τη διαχείριση θερμότητας.

- Προώθηση Συνεργασίας Οικοσυστήματος: Η εμπλοκή σε βιομηχανικά κονσόρτσιουμ και οργανισμούς τυποποίησης, όπως η OIF (Optical Internetworking Forum), μπορεί να βοηθήσει τους ενδιαφερόμενους να παραμένουν ενημερωμένοι για τις καινοτομίες διεπαφής και τις απαιτήσεις διαλειτουργικότητας.

Με την εφαρμογή αυτών των στρατηγικών συστάσεων, οι ενδιαφερόμενοι μπορούν να διασφαλίσουν ότι τα σχέδια διεπαφής HBM τους για τους επιταχυντές AI παραμένουν ισχυρά, κλιμάκωτα και μελλοντικά, υποστηρίζοντας την επόμενη γενιά φορτίων εργασίας AI.

Πηγές & Αναφορές

- Micron Technology, Inc.

- NVIDIA Corporation

- JEDEC Solid State Technology Association

- Amkor Technology, Inc.

- Cray Inc.

- Fujitsu Limited

- Synopsys, Inc.

- OIF (Optical Internetworking Forum)