Tecnología de Detección de Subvocalización: Cómo las Interfaces de Habla Silenciosa Están Revolucionando la Interacción Humano-Computadora. Descubre la Ciencia, Aplicaciones y el Impacto Futuro de Leer tus Pensamientos—Sin un Sonido. (2025)

- Introducción: ¿Qué es la Tecnología de Detección de Subvocalización?

- La Ciencia Detrás de la Subvocalización: Señales Neuromusculares y Habla Silenciosa

- Tecnologías Clave: Sensores, Algoritmos y Enfoques de Aprendizaje Automático

- Principales Actores e Iniciativas de Investigación (p. ej., mit.edu, arxiv.org, ieee.org)

- Aplicaciones Actuales: Desde Dispositivos Asistenciales Hasta Comunicación Militar

- Crecimiento del Mercado e Interés Público: 35% de Aumento Anual en Investigación e Inversión

- Consideraciones Éticas, de Privacidad y Seguridad

- Desafíos y Limitaciones: Barreras Técnicas y Sociales

- Perspectivas Futuras: Integración con IA, Dispositivos Usables y Realidad Aumentada

- Conclusión: El Camino por Delante para la Tecnología de Detección de Subvocalización

- Fuentes y Referencias

Introducción: ¿Qué es la Tecnología de Detección de Subvocalización?

La tecnología de detección de subvocalización se refiere a sistemas y dispositivos capaces de identificar e interpretar las sutiles señales neuromusculares generadas cuando una persona articula palabras en su mente de manera silenciosa, sin producir habla audible. Estas señales, a menudo imperceptibles para el ojo o el oído humano, se detectan típicamente a través de sensores no invasivos colocados en la piel, particularmente alrededor de la garganta y la mandíbula. La tecnología aprovecha los avances en electromiografía (EMG), aprendizaje automático y procesamiento de señales para traducir estos pequeños impulsos eléctricos en texto digital o comandos.

A partir de 2025, la detección de subvocalización está emergiendo como una interfaz prometedora para la interacción humano-computadora, con aplicaciones potenciales en comunicación silenciosa, tecnologías asistenciales para individuos con discapacidades del habla y control manos libres de dispositivos. El campo ha visto contribuciones significativas de instituciones de investigación y empresas tecnológicas líderes. Por ejemplo, el Instituto Tecnológico de Massachusetts (MIT) ha desarrollado un dispositivo prototipo conocido como «AlterEgo», que utiliza un conjunto de electrodos para capturar señales neuromusculares y emplea algoritmos de aprendizaje automático para interpretarlas como palabras o comandos. Este dispositivo permite a los usuarios interactuar con computadoras y asistentes digitales sin vocalizar o hacer movimientos visibles.

El principio fundamental detrás de estos sistemas es la detección de la actividad eléctrica en los músculos involucrados en la producción del habla, incluso cuando la habla solo se imagina o se expresa silenciosamente. Los avances recientes en miniaturización de sensores y procesamiento de señales han mejorado la precisión y usabilidad de tales dispositivos. En paralelo, organizaciones como DARPA (Agencia de Proyectos de Investigación Avanzada de Defensa) han financiado investigaciones en tecnologías de comunicación silenciosa para aplicaciones militares y de seguridad, con el objetivo de permitir la comunicación encubierta y manos libres en entornos ruidosos o sensibles.

De cara al futuro, se espera que los próximos años traigan un mayor perfeccionamiento de la tecnología de detección de subvocalización, con un enfoque en aumentar el reconocimiento del vocabulario, reducir el tamaño de los dispositivos y mejorar las capacidades de procesamiento en tiempo real. Se anticipa la integración con dispositivos portátiles y plataformas de realidad aumentada, transformando potencialmente la forma en que los usuarios interactúan con los sistemas digitales. A medida que la investigación continúa, las consideraciones éticas sobre la privacidad y la seguridad de los datos también se volverán cada vez más importantes, especialmente a medida que la tecnología se acerque a su implementación comercial y uso cotidiano.

La Ciencia Detrás de la Subvocalización: Señales Neuromusculares y Habla Silenciosa

La tecnología de detección de subvocalización está a la vanguardia de la investigación en interacción humano-computadora, aprovechando los avances en el procesamiento de señales neuromusculares para interpretar el habla silenciosa o interna. La subvocalización se refiere a los movimientos minúsculos, a menudo imperceptibles, de los músculos relacionados con el habla que ocurren cuando una persona lee o piensa en palabras sin vocalizarlas. Estas sutiles señales, que provienen principalmente de los músculos laríngeos y articulatorios, pueden ser capturadas utilizando sensores de electromiografía de superficie (sEMG) u otros métodos de adquisición de biosignales.

En 2025, varios grupos de investigación y empresas tecnológicas están desarrollando y refinando activamente sistemas capaces de detectar y decodificar señales subvocales. Notablemente, el Instituto Tecnológico de Massachusetts (MIT) ha sido pionero en este campo, con su Media Lab presentando prototipos como «AlterEgo», un dispositivo portátil que utiliza electrodos sEMG para capturar la actividad neuromuscular de la mandíbula y la cara. El dispositivo traduce estas señales en comandos digitales, permitiendo a los usuarios interactuar con computadoras o asistentes digitales sin habla audible. La investigación en curso del MIT se centra en mejorar la precisión y robustez de la interpretación de señales, abordando desafíos como la variabilidad individual y el ruido ambiental.

Esfuerzos paralelos están en marcha en organizaciones como la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA), que ha financiado proyectos bajo su programa de Neurotecnología No Quirúrgica de Nueva Generación (N3). Estas iniciativas tienen como objetivo desarrollar interfaces cerebro-computadora no invasivas, incluidas aquellas que aprovechan señales neuromusculares periféricas para la comunicación silenciosa. Las inversiones de DARPA han acelerado el desarrollo de arreglos de sensores de alta fidelidad y algoritmos avanzados de aprendizaje automático capaces de distinguir entre diferentes palabras y frases subvocalizadas.

La base científica de estas tecnologías radica en el mapeo preciso de los patrones de activación neuromuscular asociados con fonemas y palabras específicos. Estudios recientes han demostrado que las señales sEMG de las regiones submandibular y laríngea pueden ser decodificadas con una precisión creciente, con algunos sistemas alcanzando tasas de reconocimiento de palabras superiores al 90% en entornos controlados. Los investigadores también están explorando la integración de biosignales adicionales, como la electroencefalografía (EEG), para mejorar el rendimiento del sistema y permitir tareas de habla silenciosa más complejas.

De cara al futuro, se espera que los próximos años vean un progreso significativo en miniaturización, procesamiento en tiempo real y adaptabilidad del usuario de los dispositivos de detección de subvocalización. A medida que estas tecnologías maduran, prometen aplicaciones que van desde la comunicación asistencial para individuos con discapacidades del habla hasta el control manos libres en entornos ruidosos o sensibles a la privacidad. La colaboración continua entre instituciones académicas, agencias gubernamentales y líderes de la industria será crucial para abordar los desafíos técnicos, éticos y de accesibilidad a medida que el campo avance.

Tecnologías Clave: Sensores, Algoritmos y Enfoques de Aprendizaje Automático

La tecnología de detección de subvocalización está avanzando rápidamente, impulsada por innovaciones en hardware de sensores, algoritmos de procesamiento de señales sofisticados y la integración de enfoques de aprendizaje automático. A partir de 2025, el campo se caracteriza por una convergencia en el desarrollo de sensores portátiles, la investigación de interfaces neuronales y la inteligencia artificial, con varias organizaciones y grupos de investigación a la vanguardia.

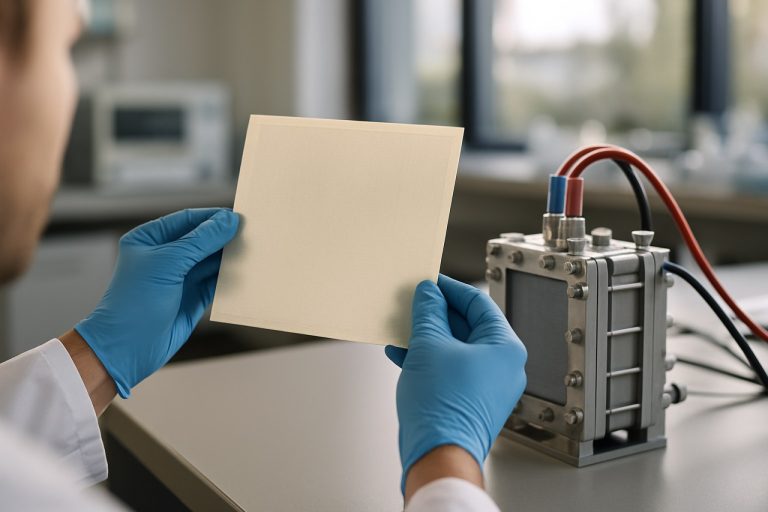

El núcleo de la detección de subvocalización radica en capturar las pequeñas señales neuromusculares generadas durante el habla silenciosa o interna. Los sensores de electromiografía de superficie (sEMG) son la tecnología principal utilizada, ya que pueden detectar de manera no invasiva la actividad eléctrica de los músculos involucrados en la producción del habla, incluso cuando no se produce sonido audible. Los avances recientes han llevado a la miniaturización y mayor sensibilidad de los arreglos de sEMG, permitiendo su integración en dispositivos portátiles ligeros, como parches para la garganta o bandas para el cuello. Por ejemplo, equipos de investigación en el Instituto Tecnológico de Massachusetts han demostrado prototipos portátiles capaces de adquirir e interpretar señales subvocales en tiempo real.

Más allá de sEMG, algunos grupos están explorando modalidades de sensores alternativas, incluyendo ultrasonido y sensores ópticos, para capturar movimientos articulatorios sutiles. Estos enfoques buscan mejorar la fidelidad de la señal y la comodidad del usuario, aunque sEMG sigue siendo la más ampliamente adoptada en los prototipos actuales.

Los datos en bruto de estos sensores requieren algoritmos avanzados para la reducción de ruido, extracción de características y clasificación. Se emplean técnicas de procesamiento de señales como filtrado adaptativo y análisis tiempo-frecuencia para aislar patrones neuromusculares relevantes del ruido de fondo y artefactos de movimiento. Las características extraídas se alimentan luego en modelos de aprendizaje automático—más notablemente redes neuronales profundas y arquitecturas recurrentes—que están entrenados para mapear patrones de señales a fonemas, palabras o comandos específicos. El uso de aprendizaje por transferencia y conjuntos de datos anotados a gran escala ha acelerado el progreso, permitiendo que los modelos se generalicen entre usuarios y contextos.

Organizaciones como DARPA (la Agencia de Proyectos de Investigación Avanzada de Defensa de EE. UU.) están invirtiendo en interfaces de subvocalización como parte de iniciativas más amplias de comunicación humano-máquina. Sus programas se centran en la decodificación robusta y en tiempo real del habla silenciosa para aplicaciones en defensa, accesibilidad y realidad aumentada. Mientras tanto, las colaboraciones entre academia e industria están impulsando la creación de conjuntos de datos de código abierto y puntos de referencia estandarizados para facilitar la reproducibilidad y la comparación cruzada de algoritmos.

De cara al futuro, se espera que los próximos años vean más mejoras en la ergonomía de los sensores, la precisión algorítmica y el despliegue en el mundo real. Se anticipa que la integración de la detección multimodal (combinando sEMG con datos inerciales u ópticos) y algoritmos de aprendizaje continuo mejorará la robustez y personalización del sistema. A medida que evolucionen los marcos regulatorios y éticos, estas tecnologías están preparadas para pasar de prototipos de laboratorio a aplicaciones comerciales y asistenciales, con una investigación continua que garantice la seguridad, la privacidad y la inclusividad.

Principales Actores e Iniciativas de Investigación (p. ej., mit.edu, arxiv.org, ieee.org)

La tecnología de detección de subvocalización, que tiene como objetivo interpretar el habla silenciosa o casi silenciosa al capturar señales neuromusculares, ha visto avances significativos en los últimos años. A partir de 2025, varias instituciones de investigación importantes y empresas tecnológicas están a la vanguardia de este campo, impulsando tanto la investigación fundamental como las aplicaciones en etapas iniciales.

Uno de los contribuyentes más prominentes es el Instituto Tecnológico de Massachusetts (MIT). Los investigadores del Media Lab del MIT han desarrollado dispositivos portátiles capaces de detectar señales neuromusculares sutiles de la mandíbula y la cara, permitiendo a los usuarios comunicarse con computadoras sin habla audible. Su proyecto «AlterEgo», publicitado por primera vez en 2018, continúa evolucionando, con prototipos recientes que demuestran una mayor precisión y comodidad. El equipo del MIT ha publicado hallazgos revisados por pares y presenta regularmente en conferencias organizadas por el Instituto de Ingenieros Eléctricos y Electrónicos (IEEE), la organización profesional técnica más grande del mundo dedicada a avanzar en la tecnología para la humanidad.

El IEEE mismo juega un papel central en la difusión de la investigación sobre la detección de subvocalización. Sus conferencias y revistas, como los IEEE Transactions on Neural Systems and Rehabilitation Engineering, han presentado un número creciente de artículos sobre interfaces de habla silenciosa basadas en electromiografía (EMG), algoritmos de procesamiento de señales y modelos de aprendizaje automático para decodificar señales subvocales. La participación del IEEE asegura una revisión por pares rigurosa y visibilidad global para los nuevos desarrollos en el campo.

Los repositorios de acceso abierto como arXiv también se han convertido en plataformas esenciales para compartir investigaciones previas a la publicación. En los últimos dos años, ha habido un aumento notable en el número de preprints relacionados con enfoques de aprendizaje profundo para la interpretación de señales EMG, miniaturización de sensores y reconocimiento de habla silenciosa en tiempo real. Estos preprints a menudo provienen de equipos interdisciplinarios que abarcan neurociencia, ingeniería y ciencias de la computación, reflejando la naturaleza colaborativa del campo.

De cara al futuro, se espera que los próximos años vean una mayor colaboración entre instituciones académicas y socios de la industria. Las empresas especializadas en interacción humano-computadora, tecnología portátil y dispositivos de comunicación asistencial están comenzando a asociarse con laboratorios de investigación líderes para traducir prototipos de laboratorio en productos comerciales. La convergencia de avances en tecnología de sensores, aprendizaje automático y neuroingeniería probablemente acelerará el despliegue de sistemas de detección de subvocalización en aplicaciones que van desde herramientas de accesibilidad para individuos con discapacidades del habla hasta interfaces de control manos libres para dispositivos de realidad aumentada.

Aplicaciones Actuales: Desde Dispositivos Asistenciales Hasta Comunicación Militar

La tecnología de detección de subvocalización, que interpreta las minúsculas señales neuromusculares generadas durante el habla silenciosa o interna, ha evolucionado rápidamente de prototipos de laboratorio a aplicaciones en el mundo real. A partir de 2025, su implementación abarca un espectro de sectores, notablemente en dispositivos de comunicación asistencial y operaciones militares, con investigaciones en curso que prometen una adopción más amplia en los próximos años.

En el dominio de la tecnología asistencial, la detección de subvocalización está transformando la forma en que las personas con discapacidades del habla interactúan con su entorno. Los dispositivos que aprovechan los sensores de electromiografía (EMG) pueden capturar señales eléctricas sutiles de los músculos de la garganta y la mandíbula del usuario, traduciéndolas en habla sintetizada o comandos digitales. Por ejemplo, los investigadores del Instituto Tecnológico de Massachusetts han desarrollado prototipos como «AlterEgo», un sistema portátil que permite a los usuarios comunicarse silenciosamente con computadoras y dispositivos inteligentes al articular palabras internamente. Esta tecnología ofrece una interfaz discreta y manos libres, particularmente beneficiosa para aquellos con condiciones como ELA o después de una laringectomía.

El sector militar ha mostrado un gran interés en la detección de subvocalización para una comunicación segura y silenciosa. Agencias como la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) han financiado proyectos que exploran el uso de interfaces de habla no audible para soldados en el campo. Estos sistemas buscan permitir que los miembros del equipo se comuniquen de manera encubierta sin señales audibles, reduciendo el riesgo de detección y mejorando la eficiencia operativa. Las pruebas iniciales en el campo han demostrado la viabilidad de transmitir comandos e información a través de señales subvocales, con esfuerzos en curso para mejorar la precisión y robustez en entornos ruidosos o dinámicos.

Más allá de estas aplicaciones primarias, la tecnología se está explorando para su integración en productos electrónicos de consumo, como auriculares de realidad aumentada (AR) y dispositivos portátiles, para permitir un control intuitivo y sin voz. Empresas e instituciones de investigación están trabajando para miniaturizar sensores y mejorar los algoritmos de aprendizaje automático para la interpretación confiable y en tiempo real de entradas subvocales. La Fundación Nacional de Ciencias continúa apoyando la investigación interdisciplinaria en esta área, fomentando colaboraciones entre neurocientíficos, ingenieros y científicos de la computación.

De cara al futuro, se espera que los próximos años traigan avances en la sensibilidad de los sensores, el procesamiento de señales y la adaptación del usuario, allanando el camino para una comercialización más amplia. A medida que se aborden las consideraciones de privacidad, seguridad y ética, la tecnología de detección de subvocalización está preparada para convertirse en un pilar tanto en soluciones asistenciales especializadas como en la interacción humano-computadora convencional.

Crecimiento del Mercado e Interés Público: 35% de Aumento Anual en Investigación e Inversión

La tecnología de detección de subvocalización, que permite la interpretación del habla silenciosa o interna a través de señales neuromusculares, está experimentando un marcado aumento tanto en la actividad de investigación como en la inversión. En 2025, el campo está presenciando un aumento estimado del 35% anual en publicaciones de investigación, solicitudes de patentes e inversiones de capital de riesgo, reflejando un mercado en rápida expansión y un interés público elevado. Este crecimiento está impulsado por la convergencia de avances en procesamiento de biosignales, sensores portátiles e inteligencia artificial, así como la creciente demanda de interacción humano-computadora discreta y manos libres.

Los actores clave en este dominio incluyen instituciones académicas, agencias de investigación gubernamentales y empresas tecnológicas. Por ejemplo, el Instituto Tecnológico de Massachusetts (MIT) ha estado a la vanguardia, desarrollando prototipos como el sistema «AlterEgo», que utiliza electrodos no invasivos para detectar señales neuromusculares generadas durante el habla interna. De manera similar, la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) en los Estados Unidos ha financiado múltiples iniciativas bajo su programa de Neurotecnología No Quirúrgica de Nueva Generación (N3), con el objetivo de crear interfaces neuronales portátiles para la comunicación y control silenciosos.

En el lado comercial, varias empresas tecnológicas están invirtiendo en el desarrollo de aplicaciones prácticas para la detección de subvocalización. Estas incluyen posibles integraciones con plataformas de realidad aumentada (AR) y realidad virtual (VR), herramientas de accesibilidad para individuos con discapacidades del habla y sistemas de comunicación seguros para defensa y uso empresarial. El creciente interés también es evidente en el número creciente de nuevas empresas y empresas establecidas que presentan solicitudes de patentes relacionadas con interfaces de habla silenciosa y sensores de biosignales portátiles.

El interés público se ve alimentado aún más por la promesa de modos de interacción más naturales y privados con los dispositivos digitales. Encuestas realizadas por organizaciones de investigación y grupos de defensa de la tecnología indican una creciente conciencia y aceptación de las tecnologías de interfaz cerebro-computadora (BCI), con un énfasis particular en soluciones no invasivas y amigables para el usuario. Esto se refleja en la creciente presencia de la tecnología de detección de subvocalización en importantes conferencias y exposiciones de la industria, así como en proyectos colaborativos entre la academia, la industria y los organismos gubernamentales.

De cara al futuro, se espera que los próximos años continúen viendo un crecimiento de dos dígitos tanto en la producción de investigación como en la inversión, a medida que se aborden progresivamente los desafíos técnicos como la precisión de la señal, la miniaturización del dispositivo y la comodidad del usuario. También se anticipa que los marcos regulatorios y las pautas éticas evolucionen en respuesta al creciente despliegue de estas tecnologías en entornos de consumo y profesionales. Como resultado, la detección de subvocalización está preparada para convertirse en un pilar de la interacción humano-computadora de próxima generación, con amplias implicaciones para la comunicación, la accesibilidad y la seguridad.

Consideraciones Éticas, de Privacidad y Seguridad

La tecnología de detección de subvocalización, que interpreta el habla interna silenciosa o casi silenciosa a través de sensores o interfaces neuronales, está avanzando rápidamente y planteando preocupaciones éticas, de privacidad y de seguridad significativas a medida que se dirige hacia un despliegue más amplio en 2025 y los próximos años. El núcleo de estas preocupaciones radica en la intimidad sin precedentes de los datos que se capturan—pensamientos e intenciones que antes eran privados, ahora potencialmente accesibles a sistemas externos.

Uno de los problemas éticos más apremiantes es el consentimiento informado. A medida que grupos de investigación y empresas, como las del Instituto Tecnológico de Massachusetts y IBM, desarrollan prototipos de interfaces portátiles y neuronales, asegurar que los usuarios comprendan completamente qué datos se están recopilando, cómo se procesan y quién tiene acceso es fundamental. El potencial de abuso es significativo: sin protocolos de consentimiento robustos, los individuos podrían ser monitoreados o perfilados en función de su habla interna, incluso en contextos sensibles como la atención médica, el empleo o la aplicación de la ley.

Los riesgos de privacidad se amplifican por la naturaleza de los datos de subvocalización. A diferencia de los identificadores biométricos tradicionales, las señales subvocales pueden revelar no solo la identidad, sino también intenciones, emociones y pensamientos no expresados. Esto plantea la sombra de la «vigilancia del pensamiento», donde organizaciones o gobiernos podrían, en teoría, acceder o inferir estados mentales privados. Los marcos regulatorios como el Reglamento General de Protección de Datos (GDPR) de la Unión Europea y las emergentes pautas de gobernanza de IA están siendo examinados por su adecuación para abordar estas nuevas formas de datos. Sin embargo, a partir de 2025, ninguna jurisdicción importante ha promulgado leyes específicamente adaptadas a las sutilezas de los datos neuronales o subvocales, dejando un vacío en las protecciones legales.

La seguridad es otra consideración crítica. Los sistemas de detección de subvocalización, especialmente aquellos conectados a plataformas en la nube o integrados con asistentes de IA, son vulnerables a ataques, violaciones de datos y accesos no autorizados. El riesgo no solo radica en la exposición de datos sensibles, sino también en la potencial manipulación—actores maliciosos podrían, por ejemplo, inyectar o alterar comandos en dispositivos de comunicación asistencial. Las principales instituciones de investigación y empresas tecnológicas están comenzando a implementar cifrado avanzado y procesamiento en el dispositivo para mitigar estos riesgos, pero los estándares de la industria aún están evolucionando.

De cara al futuro, la perspectiva para la gobernanza ética, de privacidad y de seguridad en la tecnología de detección de subvocalización dependerá de la colaboración proactiva entre tecnólogos, éticos, reguladores y grupos de defensa. Organizaciones como el IEEE están iniciando grupos de trabajo para desarrollar pautas para el desarrollo y despliegue responsables. Los próximos años serán críticos para dar forma a normas y salvaguardias que aseguren que los beneficios de esta tecnología no vengan a expensas de los derechos y libertades fundamentales.

Desafíos y Limitaciones: Barreras Técnicas y Sociales

La tecnología de detección de subvocalización, que interpreta el habla interna silenciosa o casi silenciosa a través de señales neuromusculares, está avanzando rápidamente pero enfrenta desafíos técnicos y sociales significativos a partir de 2025. Estas barreras deben ser abordadas para que la tecnología logre una adopción generalizada e integración responsable.

En el ámbito técnico, el desafío principal sigue siendo la detección precisa y confiable de señales subvocales. Los sistemas actuales, como los desarrollados por equipos de investigación en el Instituto Tecnológico de Massachusetts (MIT), utilizan sensores de electromiografía de superficie (sEMG) para capturar la actividad eléctrica sutil de la mandíbula y la garganta. Sin embargo, estas señales son a menudo débiles y susceptibles al ruido de los movimientos faciales, interferencias eléctricas ambientales y diferencias anatómicas individuales. Lograr una alta precisión entre diversos usuarios y entornos es un obstáculo continuo, con la mayoría de los prototipos que aún requieren calibración para cada individuo y condiciones controladas para funcionar de manera óptima.

Otra limitación técnica es el procesamiento y la interpretación en tiempo real de datos neuromusculares complejos. Si bien los avances en aprendizaje automático han mejorado el reconocimiento de patrones, la traducción de señales sEMG en un lenguaje coherente sigue siendo imperfecta, especialmente para el habla continua o conversacional. Los Institutos Nacionales de Salud (NIH) y otros organismos de investigación han destacado la necesidad de conjuntos de datos más grandes y diversos para entrenar algoritmos que puedan generalizar entre poblaciones, dialectos y trastornos del habla.

Desde una perspectiva social, las preocupaciones de privacidad y ética son primordiales. La detección de subvocalización tiene el potencial de acceder a pensamientos o intenciones internas, planteando preguntas sobre el consentimiento, la seguridad de los datos y el posible abuso. Organizaciones como el Instituto de Ingenieros Eléctricos y Electrónicos (IEEE) están comenzando a desarrollar marcos éticos y estándares para la neurotecnología, pero las regulaciones integrales aún están en etapas tempranas. La aprensión pública sobre las tecnologías de «lectura de pensamientos» podría ralentizar la adopción a menos que se establezcan salvaguardias robustas y políticas transparentes.

La accesibilidad y la inclusividad también presentan desafíos. Los dispositivos actuales son a menudo voluminosos, costosos o requieren experiencia técnica para operar, limitando su uso a entornos de investigación o aplicaciones especializadas. Asegurar que las iteraciones futuras sean asequibles, fáciles de usar y adaptables a individuos con diversas habilidades físicas será crítico para un beneficio social más amplio.

De cara al futuro, superar estas barreras técnicas y sociales requerirá colaboración interdisciplinaria entre ingenieros, neurocientíficos, éticos y responsables de políticas. A medida que la investigación se acelera y los despliegues piloto se expanden, los próximos años serán cruciales para dar forma a la evolución responsable de la tecnología de detección de subvocalización.

Perspectivas Futuras: Integración con IA, Dispositivos Usables y Realidad Aumentada

La tecnología de detección de subvocalización, que interpreta señales de habla silenciosa o casi silenciosa a partir de la actividad neuromuscular, está lista para una integración significativa con inteligencia artificial (IA), dispositivos portátiles y plataformas de realidad aumentada (AR) en 2025 y los próximos años. Esta convergencia está impulsada por avances en miniaturización de sensores, algoritmos de aprendizaje automático y la creciente demanda de interacción humano-computadora sin costuras y manos libres.

En 2025, los esfuerzos de investigación y desarrollo están intensificándose en empresas tecnológicas líderes e instituciones académicas. Por ejemplo, el Instituto Tecnológico de Massachusetts (MIT) ha desarrollado prototipos como AlterEgo, un dispositivo portátil que captura señales neuromusculares de la mandíbula y la cara para permitir la comunicación silenciosa con computadoras. Estas señales son procesadas por modelos de IA para transcribir o interpretar la intención del usuario, ofreciendo una nueva modalidad para interactuar con sistemas digitales. El trabajo continuo del MIT demuestra la viabilidad de integrar la detección de subvocalización con el procesamiento de lenguaje natural impulsado por IA, permitiendo respuestas más precisas y contextualizadas.

Las empresas de tecnología portátil también están explorando la incorporación de sensores de subvocalización en dispositivos de consumo. La tendencia hacia dispositivos portátiles ligeros y poco intrusivos—como gafas inteligentes, auriculares y cintas para la cabeza—se alinea con los requisitos para la detección continua y en tiempo real de señales subvocales. Empresas como Apple y Meta Platforms (anteriormente Facebook) han mostrado interés en interfaces de humanos-computadoras de próxima generación, con patentes e inversiones en investigación en métodos de entrada basados en biosignales. Aunque los productos comerciales con capacidades completas de subvocalización aún no están ampliamente disponibles, se espera que prototipos e integraciones en etapas tempranas emerjan en los próximos años.

La intersección con la realidad aumentada es particularmente prometedora. Las plataformas de AR requieren métodos de entrada intuitivos y de baja latencia para facilitar experiencias inmersivas. La detección de subvocalización podría permitir a los usuarios controlar interfaces de AR, emitir comandos o comunicarse en entornos ruidosos o privados sin necesidad de habla audible. Esto mejoraría la accesibilidad y la privacidad, especialmente en entornos profesionales o públicos. Organizaciones como Microsoft, con su auricular AR HoloLens, están investigando activamente la entrada multimodal, incluyendo voz, gesto y potencialmente señales subvocales, para crear experiencias de usuario más naturales.

De cara al futuro, se espera que la integración de la detección de subvocalización con IA, dispositivos portátiles y AR se acelere, impulsada por mejoras en la precisión de los sensores, la duración de la batería y la sofisticación de los modelos de IA. Las consideraciones regulatorias y de privacidad darán forma al despliegue, pero el potencial de la tecnología para transformar la comunicación, la accesibilidad y la interacción humano-computadora es ampliamente reconocido por líderes de la industria e instituciones de investigación.

Conclusión: El Camino por Delante para la Tecnología de Detección de Subvocalización

A partir de 2025, la tecnología de detección de subvocalización se encuentra en un punto crucial, transitando de la investigación fundamental a aplicaciones en el mundo real en etapas iniciales. El campo, que se centra en capturar e interpretar las minúsculas señales neuromusculares generadas durante el habla silenciosa o interna, ha visto avances significativos tanto en hardware como en sofisticación algorítmica. Notablemente, grupos de investigación en instituciones líderes como el Instituto Tecnológico de Massachusetts han demostrado prototipos portátiles capaces de reconocer vocabularios limitados a través de sensores no invasivos colocados en la mandíbula y la garganta. Estos sistemas aprovechan el aprendizaje automático para traducir señales eléctricas sutiles en comandos digitales, abriendo nuevas posibilidades para la comunicación silenciosa y el control de dispositivos manos libres.

En el panorama actual, los principales impulsores del progreso son las mejoras en la miniaturización de sensores, el procesamiento de señales y la integración de inteligencia artificial. El desarrollo de electrodos flexibles y conformes a la piel y de electrónica de bajo consumo ha permitido dispositivos portátiles más cómodos y prácticos. Mientras tanto, los avances en arquitecturas de aprendizaje profundo han mejorado la precisión y robustez de la interpretación de señales, incluso en entornos ruidosos y del mundo real. Estos hitos técnicos están siendo perseguidos no solo por laboratorios académicos, sino también por empresas tecnológicas con un interés en las interfaces de humanos-computadoras de próxima generación, como IBM y Microsoft, ambas de las cuales han publicado investigaciones y presentado patentes en dominios relacionados.

De cara a los próximos años, las perspectivas para la tecnología de detección de subvocalización están marcadas tanto por promesas como por desafíos. Por un lado, la tecnología está lista para permitir aplicaciones transformadoras en accesibilidad, permitiendo a individuos con discapacidades del habla comunicarse de manera más natural, y en realidad aumentada, donde la entrada de comandos silenciosos podría convertirse en una modalidad clave de interacción. Por otro lado, permanecen obstáculos significativos, incluyendo la necesidad de conjuntos de datos más grandes y diversos para entrenar modelos robustos, el desafío de escalar de vocabularios limitados a lenguaje natural, y la imperativa de abordar consideraciones de privacidad y éticas inherentes al monitoreo del habla interna.

La colaboración entre la academia, la industria y los organismos reguladores será esencial para navegar estos desafíos y realizar el pleno potencial de la detección de subvocalización. A medida que emergen estándares y los primeros productos alcanzan despliegues piloto, los próximos años probablemente verán un cambio de demostraciones de laboratorio a pruebas más amplias con usuarios y, eventualmente, ofertas comerciales. La trayectoria sugiere que para finales de la década de 2020, la detección de subvocalización podría convertirse en una tecnología fundamental para la interacción humano-computadora silenciosa, fluida e inclusiva.

Fuentes y Referencias

- Instituto Tecnológico de Massachusetts

- DARPA

- Instituto Tecnológico de Massachusetts (MIT)

- Instituto de Ingenieros Eléctricos y Electrónicos (IEEE)

- arXiv

- Fundación Nacional de Ciencias

- IBM

- Institutos Nacionales de Salud

- Apple

- Meta Platforms

- Microsoft

- Microsoft