Modele Dyfuzji w Sztucznej Inteligencji: Przemiana Zdolności Generacyjnych i Pr redefinicja Kreatywności Maszynowej. Odkryj, jak te modele kształtują przyszłość innowacji AI.

- Wprowadzenie do Modeli Dyfuzji: Pochodzenie i Kluczowe Koncepcje

- Jak Działają Modele Dyfuzji: Krok po Kroku

- Porównanie Modeli Dyfuzji z GAN i VAE

- Kluczowe Zastosowania: Od Syntez Obróbki Obrazów po Generowanie Tekstu

- Ostatnie Przełomy i Zauważalne Wdrażania

- Wyzwania i Ograniczenia Obecnych Modeli Dyfuzji

- Przyszłe Kierunki: Trendy Badawcze i Wpływ na Przemysł

- Rozważania Etyczne i Społeczne Implikacje

- Źródła i Odesłania

Wprowadzenie do Modeli Dyfuzji: Pochodzenie i Kluczowe Koncepcje

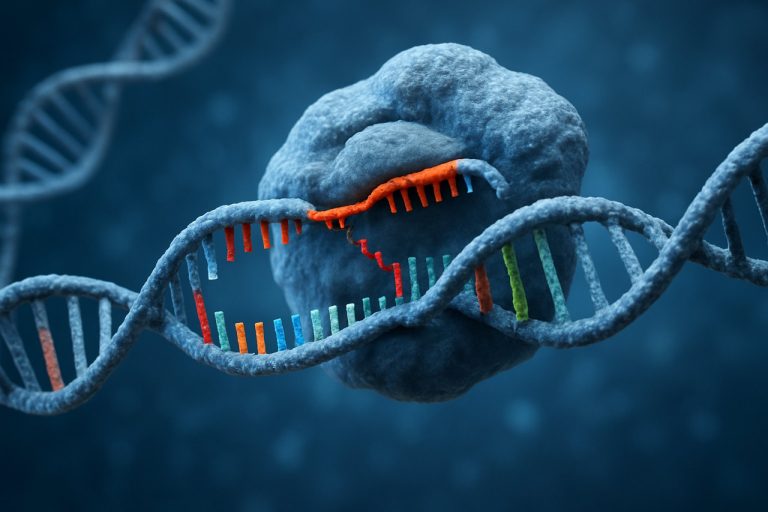

Modele dyfuzji stały się transformacyjnym podejściem w sztucznej inteligencji, szczególnie w dziedzinach modelowania generatywnego i syntezy obrazu. W swojej istocie, modele dyfuzji to probabilistyczne ramy, które uczą się generować dane, symulując stopniowy, odwracalny proces dodawania i usuwania szumów. Pochodzenie modeli dyfuzji można śledzić do badań nad termodynamiką układów nieodwracalnych i procesami stochastycznymi, gdzie koncepcja dyfuzji cząsteczek zainspirowała matematyczne podstawy tych modeli. W kontekście AI, modele dyfuzji zostały pierwszy raz sformalizowane na początku lat 2010, ale zyskały znaczną popularność po wprowadzeniu Denoising Diffusion Probabilistic Models (DDPM) przez badaczy z OpenAI i późniejszych osiągnięciach DeepMind.

Wszystko sprowadza się do dwóch procesów: procesu dyfuzji w kierunku do przodu, w którym dane są stopniowo zniekształcane przez dodawanie hałasu Gaussowskiego w kilku krokach, oraz procesu odwrotnego, w którym sieć neuronowa jest trenowana do odszumiania i rekonstrukcji oryginalnych danych z zniekształconej wersji. Ten iteracyjny proces odszumiania pozwala modelowi uczyć się złożonych rozkładów danych z niezwykłą wiernością. W przeciwieństwie do tradycyjnych modeli generatywnych, takich jak GAN czy VAE, modele dyfuzji znane są ze swojej stabilności podczas treningu oraz zdolności do produkcji próbek wysokiej jakości i różnorodnych. Ich teoretyczna podstawa jest ściśle związana z modelowaniem generatywnym opartym na ocenach, jak badano na Uniwersytecie Kalifornijskim w Berkeley. Dziś modele dyfuzji są fundamentem najnowocześniejszych systemów w generacji obrazów, dźwięku, a nawet tekstu, co oznacza znaczną ewolucję w dziedzinie sztucznej inteligencji.

Jak Działają Modele Dyfuzji: Krok po Kroku

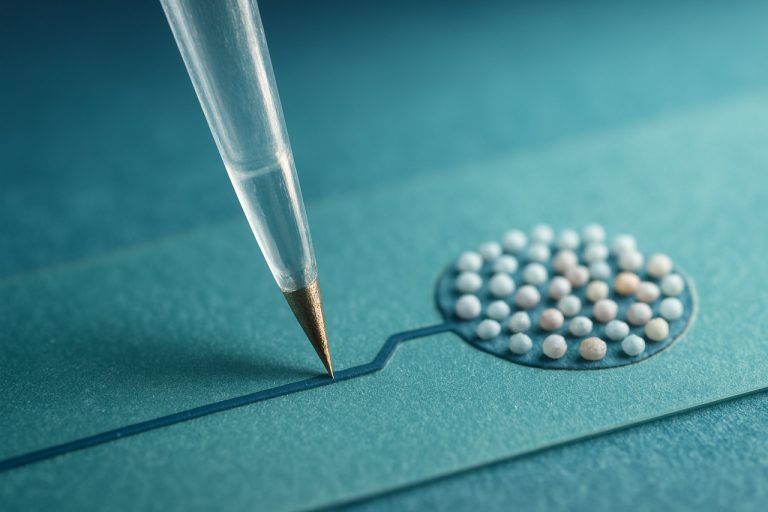

Modele dyfuzji w sztucznej inteligencji generują dane — głównie obrazy — przez symulowanie stopniowego, krok po kroku procesu, który przekształca losowy hałas w spójne wyniki. Proces toczy się w dwóch głównych fazach: procesie do przodu (dyfuzji) i procesie odwrotnym (odszumiania).

W procesie do przodu, próbka danych (na przykład obraz) jest stopniowo zniekształcana przez dodawanie małych ilości szumu w wielu krokach, co w efekcie zamienia ją w czysty hałas. Proces ten jest matematycznie zdefiniowany, tak aby każdy krok był przewidywalny i odwracalny. Celem jest nauczenie się, jak dane ulegają degradacji, co jest niezbędne dla modelu, aby później odwrócić ten proces.

Proces odwrotny to miejsce, w którym tkwi generatywna moc modelu. Tutaj sieć neuronowa jest trenowana, aby stopniowo usunąć szum z losowego wejścia, krok po kroku, rekonstrukując oryginalny rozkład danych. Na każdym etapie model przewiduje komponent szumu i go odejmuje, przybliżając próbkę do realistycznego wyniku. To odszumianie powtarza się setki lub tysiące razy, przy czym model uczy się dokonywać coraz dokładniejszych prognoz na każdym etapie.

Trening polega na narażaniu modelu na wiele par danych z hałasem i czystych danych, optymalizując go do przewidywania dodawanego hałasu na każdym kroku. Po treningu model może rozpocząć od czystego hałasu i iteracyjnie generować nowe, wysokiej jakości próbki. To podejście umożliwiło uzyskanie najnowocześniejszych wyników w syntezie obrazów i innych zadaniach generatywnych, co zostało udowodnione przez modele takie jak OpenAI i Stability AI.

Porównanie Modeli Dyfuzji z GAN i VAE

Modele dyfuzji, Generative Adversarial Networks (GAN) oraz Variational Autoencoders (VAE) reprezentują trzy znaczące podejścia w modelowaniu generatywnym w sztucznej inteligencji. Każda z metod ma odrębne mechanizmy i kompromisy, szczególnie pod względem jakości próbek, stabilności treningu i interpretowalności.

GAN wykorzystują ramy teorii gier, stawiając generator na przeciwko dyskryminatorowi, aby produkować realistyczne próbki danych. Chociaż GAN są znane z generowania obrazów o wysokiej wierności, często cierpią z powodu niestabilności treningu oraz problemów, takich jak zapadanie się trybów, gdzie generator produkuje ograniczone rodzaje wyników. Z drugiej strony, VAE korzystają z probabilistycznych kodowań i dekodowań, optymalizując dolny limit wariacyjny, aby uczyć się ukrytych reprezentacji. VAE są ogólnie bardziej stabilne podczas treningu i oferują interpretowalne przestrzenie ukryte, ale ich wyniki są zazwyczaj bardziej rozmyte w porównaniu do GAN i modeli dyfuzji.

Modele dyfuzji, takie jak te spopularyzowane przez OpenAI i Stability AI, iteracyjnie przekształcają hałas w dane poprzez szereg kroków odszumiania. Proces ten, inspirowany termodynamiką układów nieodwracalnych, pozwala na bardzo stabilny trening i wyjątkową różnorodność próbek. Ostatnie benchmarki wykazały, że modele dyfuzji mogą przewyższać GAN pod względem jakości obrazów, mierzonej za pomocą metryk takich jak FID (Fréchet Inception Distance), i są mniej podatne na zapadanie się trybów. Jednak modele dyfuzji są intensywne obliczeniowo, wymagając setek lub tysięcy przejść do przodu, aby wygenerować jedną próbkę, podczas gdy GAN i VAE są zazwyczaj znacznie szybsze podczas inferencji.

Podsumowując, modele dyfuzji oferują atrakcyjny balans stabilności i jakości próbek, przewyższając GAN i VAE w kilku dziedzinach, chociaż kosztem zwiększonych wymagań obliczeniowych. Bieżące badania mają na celu przyspieszenie próbkowania dyfuzji i dalsze zacieśnienie luki wydajnościowej z GAN i VAE (DeepMind).

Kluczowe Zastosowania: Od Syntez Obróbki Obrazów po Generowanie Tekstu

Modele dyfuzji szybko stały się transformacyjnym podejściem w sztucznej inteligencji, szczególnie osiągając doskonałość w zadaniach generatywnych w wielu dziedzinach. Ich najbardziej prominentne zastosowanie dotyczy syntezy obrazów, gdzie modele takie jak DALL·E 2 i Stable Diffusion wykazały zdolność do generowania wysoce realistycznych i różnorodnych obrazów na podstawie tekstowych podpowiedzi lub nawet z zniekształconych wejść. Modele te iteracyjnie przekształcają losowy hałas w spójne obrazy, umożliwiając kreatywne zastosowania w sztuce, designie i rozrywce. Na przykład, DALL·E 2 od OpenAI może produkować szczegółowe treści wizualne, które ściśle odpowiadają opisanemu przez użytkownika, rewolucjonizując procesy tworzenia treści.

Poza generowaniem obrazów, modele dyfuzji dokonują znaczących postępów w generowaniu i manipulacji tekstu. Ostatnie badania dostosowały proces dyfuzji do danych dyskretnych, co pozwala na generację spójnych i kontekstowo odpowiednich tekstów. To podejście oferuje przewagi w kontrolowalności i różnorodności w porównaniu do tradycyjnych modeli autoregresywnych. Na przykład, model Imagen od Google DeepMind wykorzystuje dyfuzję do zadań z zakresu obrazów i tekstów, prezentując elastyczność tego frameworku.

Inne kluczowe zastosowania obejmują syntezę audio, generację wideo oraz projektowanie molekularne, gdzie modele dyfuzji są wykorzystywane do generowania nowych molekuł o pożądanych właściwościach. Ich zdolność do modelowania złożonych rozkładów danych czyni je odpowiednimi do zadań wymagających wysokiej wierności i kreatywności. W miarę postępu badań oczekuje się, że modele dyfuzji będą miały coraz większy wpływ na różnorodne przemysły oparte na AI, od służby zdrowia po rozrywkę i nie tylko.

Ostatnie Przełomy i Zauważalne Wdrażania

Ostatnie lata były świadkiem niezwykłych przełomów w rozwoju i zastosowaniu modeli dyfuzji w sztucznej inteligencji, szczególnie w dziedzinach generowania obrazów, audio i wideo. Jednym z najbardziej prominentnych osiągnięć jest wprowadzenie DALL·E 2 od OpenAI, które korzysta z modeli dyfuzji do generowania wysoce realistycznych i różnorodnych obrazów na podstawie opisów tekstowych. Model ten wykazał znaczący skok zarówno w wierności, jak i kontrolowalności w porównaniu do wcześniejszych podejść generatywnych.

Inną znaczącą implementacją jest Stable Diffusion od Stability AI, open-source’owy model dyfuzji tekst-na-obraz, który zdemokratyzował dostęp do wysokiej jakości narzędzi generatywnych. Jego wydanie wywołało falę innowacji i dostosowań, umożliwiając badaczom i artystom dostosowywanie modeli do konkretnych zadań kreatywnych. Podobnie, Badania Google's Imagen zaprezentowały stan fotorealizmu i rozumienia semantycznego, dalej przesuwając granice możliwości modeli dyfuzji.

Poza syntezami obrazów, modele dyfuzji zostały z powodzeniem dostosowane do generacji audio, jak pokazano w WaveNet od DeepMind oraz w bardziej współczesnych systemach generacji muzyki. W wideo modele, takie jak VideoLDM od NVIDIA, rozpoczęły generowanie spójnych i czasowo konsekwentnych klipów wideo na podstawie podpowiedzi tekstowych, co stanowi znaczący krok naprzód w multimodalnej generatywnej AI.

Te przełomy podkreślają wszechstronność i moc modeli dyfuzji, które wciąż wyznaczają nowe standardy w zadaniach generatywnych i inspirują szybko rozwijający się ekosystem badań oraz zastosowań w dziedzinach kreatywnych i naukowych.

Wyzwania i Ograniczenia Obecnych Modeli Dyfuzji

Pomimo ich niezwykłego sukcesu w generowaniu obrazów o wysokiej wierności, audio i innych modalności danych, modele dyfuzji w sztucznej inteligencji napotykają na kilka znaczących wyzwań i ograniczeń. Jednym z głównych problemów jest ich nieefektywność obliczeniowa: trening i próbkowanie z modeli dyfuzji zazwyczaj wymagają setek lub tysięcy iteracyjnych kroków, co prowadzi do wysokich kosztów obliczeniowych i wolnych czasów inferencji w porównaniu do alternatywnych modeli generatywnych, takich jak GAN czy VAE. Ta nieefektywność może utrudniać ich wdrażanie w środowiskach wymagających szybkości lub niedoborów zasobów (DeepMind).

Innym ograniczeniem jest trudność w kontrolowaniu i warunkowaniu wyników modeli dyfuzji. Chociaż ostatnie postępy wprowadziły techniki generacji kierowanej (np. kierowanie klasyfikatorem, warunkowanie tekstowe), osiągnięcie precyzyjnej i wiarygodnej kontroli nad generowanym treścią pozostaje otwartym problemem badawczym. Jest to szczególnie istotne w przypadkach, które wymagają dokładnego przestrzegania przez użytkownika poleceń lub ograniczeń (OpenAI).

Ponadto modele dyfuzji są podatne na problemy takie jak zapadanie się trybów, gdzie różnorodność generowanych próbek jest ograniczona, oraz na przeuczenie, zwłaszcza gdy są trenowane na małych lub stronniczych zbiorach danych. Ich wydajność może również ulegać pogorszeniu, gdy są stosowane do danych niezgodnych z rozkładem, co budzi obawy dotyczące odporności i generalizacji (Cornell University arXiv).

Wreszcie, interpretowalność modeli dyfuzji pozostaje w tyle w stosunku do niektórych innych architektur AI, co utrudnia diagnozowanie błędów lub rozumienie bazowego procesu generatywnego. Rozwiązywanie tych wyzwań jest aktywnym obszarem badań, z bieżącymi wysiłkami na rzecz poprawy efektywności, kontrolowalności, odporności i przejrzystości w modelowaniu generatywnym opartym na dyfuzji.

Przyszłe Kierunki: Trendy Badawcze i Wpływ na Przemysł

Przyszłość modeli dyfuzji w sztucznej inteligencji oznaczona jest szybkim rozwojem badań i rosnącym przyjęciem w przemyśle. Jednym z wyraźnych trendów jest dążenie do bardziej efektywnych i skalowalnych architektur. Obecne modele dyfuzji, mimo swej potęgi, są intensywne obliczeniowo, co skłania badaczy do poszukiwań technik przyspieszających, takich jak polepszone algorytmy próbkowania i destylacja modeli. Te wysiłki mają na celu zredukowanie czasu inferencji i wymagań dotyczących zasobów, czyniąc modele dyfuzji bardziej praktycznymi dla zastosowań w rzeczywistości (DeepMind).

Innym istotnym kierunkiem jest rozszerzenie modeli dyfuzji poza generację obrazów. Badacze badają zastosowania w syntezie audio, generacji wideo, a nawet projektowaniu molekularnym, wykorzystując zdolność modeli do uchwycenia złożonych rozkładów danych. Ta wszechstronność międzydziedzinowa ma szansę napędzić innowacje w branżach takich jak rozrywka, służba zdrowia i nauka o materiałach (OpenAI).

Wpływ na przemysł jest już widoczny, ponieważ wiodące firmy technologiczne integrują modele dyfuzji w narzędziach kreatywnych, platformach generacji treści i procesach projektowych. Wraz z tymi modelami stającymi się coraz bardziej dostępnymi, kwestie etyczne i odpowiedzialne wdrażanie zyskują na znaczeniu, szczególnie w kontekście prywatności danych, łagodzenia biasu i autentyczności treści (National Institute of Standards and Technology). Bieżąca współpraca między akademią a przemysłem ma szansę ukształtować kolejną generację modeli dyfuzji, balansując innowacje z potrzebami społecznymi i ramami regulacyjnymi.

Rozważania Etyczne i Społeczne Implikacje

Szybki rozwój i wdrażanie modeli dyfuzji w sztucznej inteligencji (AI) rodzą istotne kwestie etyczne i społeczne implikacje. Modele te, zdolne do generowania wysoce realistycznych obrazów, dźwięków i tekstu, stawiają przed społeczeństwem zarówno szanse, jak i wyzwania. Głównym zmartwieniem jest potencjalne nadużycie, takie jak tworzenie deepfake’ów czy wprowadzających w błąd treści, które mogą podważać zaufanie publiczne i sprzyjać rozprzestrzenianiu dezinformacji. To ryzyko jest potęgowane przez rosnącą dostępność i zaawansowanie narzędzi generatywnych opartych na dyfuzji, które mogą być wykorzystywane przez złowrogie jednostki do manipulowania mediami na dużą skalę (UNESCO).

Inna kwestia etyczna dotyczy własności intelektualnej i zgody. Modele dyfuzji często są trenowane na ogromnych zbiorach danych zebranych z internetu, czasem bez wyraźnej zgody twórców treści. To rodzi pytania dotyczące naruszenia praw autorskich i praw artystów oraz właścicieli danych (Światowa Organizacja Własności Intelektualnej). Ponadto zdolność tych modeli do replikowania stylów artystycznych lub generowania treści, które są nieodróżnialne od dzieł stworzonych przez ludzi, wyzwań wobec tradycyjnych pojęć autorstwa i oryginalności.

Implicacje społeczne obejmują również potencjalne uprzedzenia i dyskryminację. Jeśli dane treningowe zawierają stronnicze lub uprzedzone informacje, modele dyfuzji mogą niezamierzenie utrwalać lub amplifikować te uprzedzenia w swoich wynikach, prowadząc do niesprawiedliwych lub szkodliwych skutków (Organizacja Współpracy Gospodarczej i Rozwoju). Rozwiązanie tych problemów wymaga solidnych ram zarządzania, przejrzystości w rozwoju modeli oraz ciągłego dialogu między zainteresowanymi stronami, aby zapewnić, że korzyści z modeli dyfuzji są realizowane przy jednoczesnym minimalizowaniu szkód.

Źródła i Odesłania

- DeepMind

- Uniwersytet Kalifornijski, Berkeley

- DeepMind

- Badania Google's Imagen

- VideoLDM od NVIDIA

- Cornell University arXiv

- Narodowy Instytut Standardów i Technologii

- UNESCO

- Światowa Organizacja Własności Intelektualnej