解锁高带宽内存的力量:HBM接口设计如何在2025及以后彻底改变AI加速器。探讨塑造下一代AI硬件的技术、市场增长和战略机会。

- 执行摘要:关键发现与战略洞察

- 市场概览:2025年AI加速器的HBM接口设计

- 技术环境:HBM标准和架构的演变

- 竞争分析:领先企业和创新趋势

- 市场规模与预测(2025–2030):CAGR、收入预测和地区拆解

- 驱动因素与挑战:性能需求、能效和集成复杂性

- 新兴应用:AI、高性能计算、数据中心和边缘计算

- 供应链和生态系统分析

- 未来展望:颠覆性技术和下一代HBM接口

- 利益相关者的战略建议

- 来源及参考

执行摘要:关键发现与战略洞察

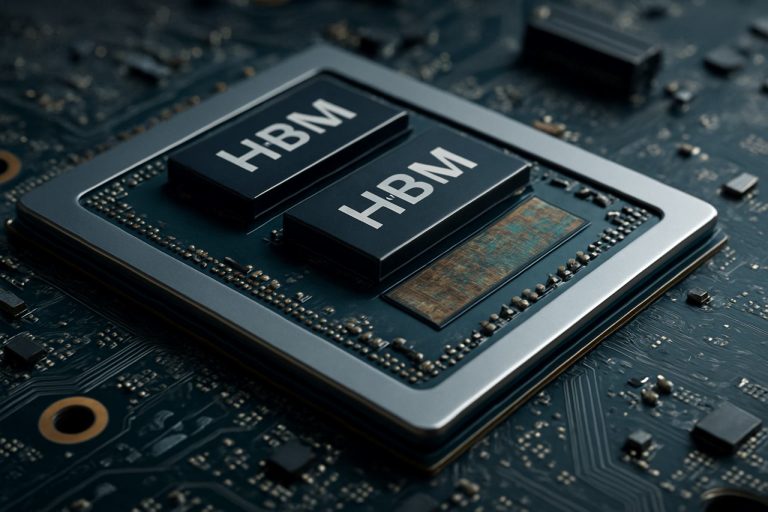

高带宽内存(HBM)接口设计已成为下一代AI加速器的关键推动者,应对数据密集型应用对内存带宽、能效和紧凑外形日益增长的需求。在2025年,AI工作负载的快速发展,尤其是在深度学习和大语言模型领域,进一步加剧了对内存解决方案的需求,这些解决方案可以提供每秒数TB的带宽,同时最大限度减少延迟和功耗。HBM凭借其3D堆叠架构和硅通孔(TSV)技术,已成为领先AI加速器供应商首选的内存接口。

关键发现表明,HBM3的采用以及HBM4的预期推出正在设定新的带宽基准,其中HBM3每堆叠提供高达819 GB/s的带宽,而HBM4预计将超过1 TB/s。这些进展使AI加速器能够实时处理更大的数据集,显著提高训练和推理的吞吐量。三星电子有限公司、美光科技有限公司和SK hynix Inc.等主要行业参与者处于HBM创新的前沿,与AI硬件设计师紧密合作,优化接口协议和信号完整性。

战略洞察表明,成功的HBM接口设计依赖于多个因素:先进的封装技术(如2.5D和3D集成)、强大的热管理,以及与AI处理核心的内存控制器的协同设计。AMD和NVIDIA公司等公司正利用这些战略,推出性能惊人的AI加速器。此外,HBM与基于芯片的架构的集成正日渐受到关注,为未来AI系统提供模块化和可扩展性。

展望未来,HBM接口生态系统预计将受益于由JEDEC固态技术协会主导的标准化工作,这些工作正在简化互操作性并加速新内存解决方案的上市时间。随着AI模型的复杂性不断增长,HBM接口设计与不断演变的AI工作负载的战略对齐将对维持AI硬件领域的竞争优势至关重要。

市场概览:2025年AI加速器的HBM接口设计

2025年,高带宽内存(HBM)接口设计在AI加速器市场预计将实现显著增长,推动力来自于人工智能和机器学习工作负载日益增长的计算需求。HBM作为一项3D堆叠DRAM技术,与传统内存解决方案相比,提供了显著改善的内存带宽和能效,成为下一代AI加速器的关键推动者。

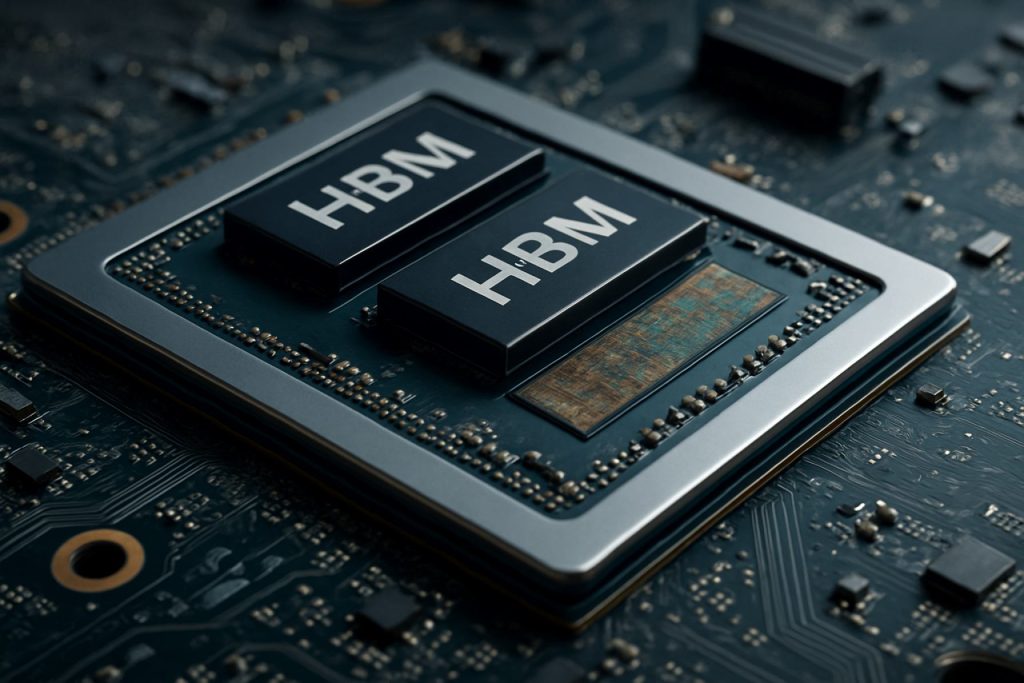

在2025年,HBM接口的采用正在被领先的半导体公司和超大规模数据中心运营商加速,他们寻求克服AI训练和推理任务中固有的内存瓶颈。最新的HBM标准,如HBM3和新兴的HBM3E,提供每个设备超过1 TB/s的带宽,支持大语言模型和生成AI系统的并行处理需求。三星电子有限公司、美光科技有限公司和SK hynix Inc.等公司在HBM开发的前沿,为AI加速器设计迅速集成内存解决方案。

AI加速器中HBM的接口设计愈发复杂,需要先进的封装技术,如2.5D和3D集成。这些方法使HBM堆叠与处理单元之间的物理接近度大幅缩小,从而最小化延迟并最大化数据吞吐量。台积电(TSMC)和英特尔公司等半导体代工厂正在投资于先进的衬底和封装解决方案,以支持这些架构。

HBM驱动的AI加速器在云数据中心、边缘计算和高性能计算(HPC)领域的需求特别强劲。包括NVIDIA公司和AMD在内的主要AI芯片供应商正在将HBM集成到其旗舰产品中,以提供当前最先进的AI模型所需的内存带宽。不断变化的标准也在塑造竞争格局,例如由JEDEC固态技术协会定义的新HBM规格,以满足未来AI的需求。

总体而言,2025年AI加速器的HBM接口设计市场具有快速创新、半导体供应链中的战略合作伙伴关系以及对带宽、能效和可扩展性的持续关注,以支持下一波AI进展。

技术环境:HBM标准和架构的演变

高带宽内存(HBM)接口设计的技术环境迅速演变,以满足AI加速器日益增长的需求。自推出以来,HBM经历了几代改进,每一代都提供了更高的带宽、更大的容量和更好的能效。最初的HBM标准由三星电子有限公司与SK hynix Inc.以及AMD协作开发,奠定了将DRAM芯片垂直堆叠并通过硅通孔(TSV)连接的基础,支持宽I/O和低功耗。

HBM2和HBM2E标准由JEDEC固态技术协会认可,进一步提高了每堆栈的带宽和容量,支持每个引脚高达3.6 Gbps和每堆栈16 GB。这些改进对AI加速器至关重要,因为AI加速器需要快速访问大量数据集和模型。最新的HBM3标准于2022年推出,推动带宽超过每引脚6.4 Gbps和每堆叠高达24 GB,美光科技有限公司和SK hynix Inc.是首批宣布HBM3产品的公司。预计在2025年广泛采用的HBM3E将在速度和热管理方面提供更高的性能,以满足下一代AI工作负载的需求。

在架构上,HBM与AI加速器的集成已从传统的侧并放置PCB转变为2.5D和3D封装,如硅衬底和先进的芯片设计。NVIDIA公司和AMD在其GPU和AI加速器中率先采用HBM,利用这些封装技术最大程度地减少信号损失并最大化内存带宽。同时,采用共封装光学和芯片内存控制器也正在兴起,进一步减少延迟和功耗。

展望2025年,HBM接口设计的环境以专注于可扩展性、能效和集成灵活性为特征。行业领导者正在协同开发新标准和参考架构,以确保互操作性,并支持AI模型的规模和复杂度的指数增长。随着AI加速器不断推动性能极限,HBM标准和架构的演变仍然是该领域创新的基石。

竞争分析:领先企业和创新趋势

高带宽内存(HBM)接口设计在AI加速器中的竞争格局正在迅速演变,受到人工智能工作负载日益增长的需求和内存与处理单元之间高效、高速数据传输的需乞驱动。三星电子有限公司、美光科技有限公司和SK hynix Inc.等主要行业参与者主导HBM制造领域,各自推出了下一代HBM(HBM2E、HBM3等),带宽、容量和能效持续提升。

在AI加速器方面,NVIDIA公司和AMD等公司已经将HBM集成到其旗舰GPU和数据中心加速器中,利用内存的宽接口和3D堆叠来最大限度地减少深度学习和高性能计算应用中的瓶颈。英特尔公司也在其AI和HPC产品中采用HBM,专注于优化接口以实现更低的延迟和更高的吞吐量。

HBM接口设计中的创新趋势集中在最大化带宽的同时降低功耗和物理占用空间。通过采用先进的硅通孔(TSV)架构、改进信号完整性和动态电压/频率调整等技术,正在解决这些挑战。HBM3的采用和HBM4的开发(由JEDEC固态技术协会主导)正在推动内存带宽的边界,HBM3的目标是实现超过每堆叠800 GB/s的速度,而HBM4预计将显著超越这一点。

另一个显著趋势是采用先进的封装技术,如2.5D和3D集成,进行HBM与AI加速器的共封装。台积电(TSMC)和安靠科技公司在提供这些封装解决方案方面处于前沿,使更紧密的集成和改进的热管理成为可能。这种共设计的方法对下一代AI系统至关重要,因为内存带宽和靠近计算单元的距离直接影响性能和效率。

总之,HBM接口设计在AI加速器中的竞争动态受到快速创新、内存和芯片制造商之间的战略合作伙伴关系以及不断追求更高带宽和更低功耗解决方案以满足AI驱动的工作负载需求的推动。

市场规模与预测(2025–2030):CAGR、收入预测和地区拆解

高带宽内存(HBM)接口设计在AI加速器的市场预计在2025年至2030年间将实现强劲增长,推动力来自于人工智能、机器学习和数据中心应用中对高性能计算的日益增长的需求。全球HBM接口市场预计在此期间将注册约25-30%的年复合增长率(CAGR),反映了HBM驱动的AI加速器在企业和云环境中的快速采用。

收入预测显示,到2025年,市场规模估计为25亿美元,到2030年可能会超过75亿美元。这一激增归因于HBM在下一代AI芯片中的不断集成,这些芯片需要超高速内存接口以处理大量的并行计算工作负载。三星电子有限公司、美光科技有限公司和SK hynix Inc.等关键行业参与者正在大力投资于研发,以推动HBM接口技术的进步,进一步促进市场扩张。

从地区来看,亚太地区预计将在2030年占据HBM接口设计市场的主导地位,预计将占全球收入的45%以上。这一主导地位得益于韩国、台湾和中国等国家内主要半导体代工厂和内存制造商的存在。北美紧随其后,主要得益于美国和加拿大AI加速器开发商和超大规模数据中心的集中。欧洲在汽车AI和工业自动化领域也持续增长。

边缘计算、自动驾驶汽车和高频交易中AI驱动的应用的普及也进一步加速了先进HBM接口的采用。随着AI模型变得更加复杂和数据密集,推动芯片设计师采用HBM2E、HBM3和新兴的HBM4标准,如JEDEC固态技术协会所定义的,这一趋势愈加明显。

总之,预计HBM接口设计市场将在2030年前实现显著扩张,亚太和北美地区强劲增长,且向更高带宽和更高效能的内存解决方案趋势明显。

驱动因素与挑战:性能需求、能效和集成复杂性

人工智能(AI)工作负载的快速演变对内存子系统提出了前所未有的要求,使高带宽内存(HBM)成为下一代AI加速器的关键推动者。HBM接口的设计必须解决几个关键驱动因素和挑战,尤其是在性能、能效和集成复杂性方面。

性能需求:AI加速器需要海量内存带宽来支持数据密集型计算引擎,尤其是涉及数十亿参数的深度学习模型。HBM以其3D堆叠架构和宽I/O,提供超过1 TB/s的最新代带宽。然而,在实践中实现这一目标需要精心的接口设计,以最小化延迟、最大化吞吐量并确保在高速数据下的信号完整性。接口还必须支持AI工作负载典型的高效数据移动模式,如大规模矩阵乘法和张量运算,这对内存控制器和互连提出了额外压力。

能效:随着AI加速器的扩展,功耗成为一个关键约束,无论是对于数据中心的部署还是边缘应用。与传统的DDR内存相比,HBM因接近处理器以及采用硅通孔(TSV)而降低了每比特的能量消耗。然而,接口设计必须通过采用先进的信号技术、动态电压和频率调整以及智能电源管理,进一步优化能量。尤其在内存堆栈的容量和速度增长时,平衡高带宽与低功耗运行是一个持续挑战。诸如三星电子有限公司和美光科技有限公司等组织正在积极开发新一代HBM,以提高能效。

集成复杂性:将HBM与AI加速器的集成涉及重大封装和系统级挑战。内存芯片的物理堆叠以及通过硅衬底或先进基板连接到处理器需要精确的制造和热管理。信号完整性、电磁干扰和机械应力都必须得到解决,以确保可靠运行。此外,接口必须与不断演变的标准(例如JEDEC固态技术协会定义的标准)兼容,以确保互操作性和未来的可扩展性。随着加速器采用基于芯片的架构,复杂性增加,需要强大的HBM接口解决方案来支持异构集成。

总之,2025年AI加速器的HBM接口设计受到了提供极端带宽、维护能效和管理先进集成复杂性的需求的影响,同时保持对AI硬件快速创新的跟进。

新兴应用:AI、高性能计算、数据中心和边缘计算

人工智能(AI)、高性能计算(HPC)、数据中心和边缘计算的快速演变正在推动对内存带宽和效率的前所未有的需求。高带宽内存(HBM)接口设计已成为AI加速器的基石技术,使现代深度学习和分析工作负载所需的大规模并行性和数据吞吐量成为可能。HBM通过将多个DRAM芯片垂直堆叠并通过硅通孔(TSV)连接,显著提高带宽并降低功耗,与传统内存接口相比取得了显著优势。

在AI加速器中,例如NVIDIA公司和AMD开发的加速器,HBM接口对于向成千上万的处理核心提供数据至关重要,而没有瓶颈。最新的HBM3和HBM3E标准,由JEDEC固态技术协会定义,支持每堆叠超过1 TB/s的带宽,这对于训练大规模神经网络和在数据中心进行实时推理至关重要。这些接口与加速器芯片紧密集成,采用如2.5D和3D集成等先进封装技术,最大程度地减少信号损失和延迟。

在HPC环境中,HBM的高带宽和能效被用于加速科学模拟、金融建模和其他数据密集型任务。由Cray公司和富士通有限公司建立的超级计算机利用HBM使处理性能达到千万亿级和万亿次性能目标。接口设计必须解决信号完整性、热管理和错误纠正等挑战,以确保在极端工作负载下的可靠运行。

要求紧凑外形和低功耗的边缘计算设备也开始采用HBM接口。三星电子有限公司和SK hynix Inc.等公司正在开发针对边缘AI芯片量身定制的HBM解决方案,以平衡带宽需求与严格的功率和热限制。

展望2025年,持续优化HBM接口设计对于支持下一代AI、HPC和边缘应用至关重要。封装、信号传输和内存控制器架构方面的创新将进一步增强AI加速器的可扩展性和效率,确保内存带宽能够跟上计算需求的指数增长。

供应链和生态系统分析

高带宽内存(HBM)接口设计在AI加速器中的供应链和生态系统特点是复杂的半导体制造商、内存供应商、代工厂和设计工具提供商的网络。HBM凭借其垂直堆叠的DRAM芯片和宽接口,成为AI加速器的关键推动者,提供大规模机器学习工作负载所需的带宽和能效。HBM接口的设计与集成需要内存供应商(如三星电子有限公司、美光科技有限公司和SK hynix Inc.)与领先的AI芯片设计师(如NVIDIA公司和AMD)之间密切合作。

这一生态系统还获得了先进封装和互连技术的支持,如硅衬底和2.5D/3D集成,由台积电(TSMC)和英特尔公司等代工厂提供。这些代工厂确保HBM堆叠与逻辑芯片的物理集成,在高速数据率下保障信号完整性和热管理。EDA工具提供商,如Synopsys, Inc.和Cadence Design Systems, Inc.,提供专门的IP和验证解决方案,以满足HBM接口严格的时间、功率和可靠性要求。

由JEDEC固态技术协会等组织主导的标准化工作在定义HBM接口规格和确保供应链间的互操作性方面发挥着关键作用。HBM标准(例如HBM3、HBM3E)的快速演变要求生态系统参与者不断更新其设计流程和制造工艺。此外,数据中心和边缘设备中对AI加速器的需求增长正在推动对产能扩展和供应链弹性的投资,这在近期主要内存和代工合作伙伴的公告中有所体现。

总之,2025年AI加速器的HBM接口设计生态系统的特点是内存供应商、芯片设计者、代工厂、EDA供应商和标准组织之间的深度相互依赖。这种协同环境对于提供下一个代AI工作负载所需的高性能、能效内存子系统至关重要。

未来展望:颠覆性技术和下一代HBM接口

高带宽内存(HBM)接口设计的未来正处于重大变革之中,颠覆性技术和下一代HBM标准的演变推动这一进程。随着AI工作负载不断需要更高的内存带宽和更低的延迟,行业正从HBM2E和HBM3迈向更先进的解决方案,例如HBM3E和对HBM4的早期研究。这些新标准有望提供前所未有的数据传输速率,HBM3E目标是实现每引脚高达9.2 Gbps的速度和每堆叠超过1.2 TB/s的总带宽,这是实现规模化AI训练和推理的关键飞跃(三星电子)。

颠覆性接口技术也正在兴起,以解决堆叠更多内存芯片和提高I/O密度所固有的信号完整性、电力传输和热管理挑战。采用先进硅通孔(TSV)架构、改进的衬底材料以及基于芯片的设计正在实现AI加速器与HBM堆叠之间的更紧密集成。例如,正在探索硅桥和有机衬底的使用,以降低成本并提高可扩展性,同时保持下一代HBM所需的高速信号传输(AMD)。

展望未来,HBM与新兴的AI加速器架构的集成,例如利用2.5D和3D封装,将进一步模糊内存与计算之间的界限。这种共封装方法预计将最小化数据传输、降低能耗,并为大型语言模型和生成AI工作负载解锁新的并行性。行业领袖还在合作开发新的接口协议和错误纠正方案,以确保在内存带宽飙升时的可靠性和可扩展性(美光科技有限公司)。

总之,HBM接口设计在AI加速器的未来将受到内存技术快速进步、封装创新和系统级共设计的影响。这些发展将重新定义2025年及以后的AI硬件性能边界,推动机器学习和数据分析领域的下一波突破。

利益相关者的战略建议

随着AI加速器越来越依赖高带宽内存(HBM)来满足大规模机器学习和深度学习工作负载的需求,各利益相关者,包括芯片设计师、系统集成商和数据中心运营商,必须采取前瞻性的策略来优化HBM接口设计。以下建议旨在应对2025年及以后的AI硬件HBM集成不断演变的格局。

- 优先考虑内存和计算的共设计:内存和计算团队之间的协作开发至关重要。通过共同优化HBM接口与AI加速器的架构,利益相关者可以最小化延迟并最大化吞吐量。三星电子有限公司和美光科技有限公司在其最新的HBM解决方案中展示了这种集成方法的好处。

- 采用最新的HBM标准:跟上最新的HBM标准,例如HBM3和新兴的HBM4,可以确保兼容性并获取更高的带宽和改进的能效。JEDEC固态技术协会定期更新这些标准,及早采用能够提供竞争优势。

- 投资先进的封装技术:2.5D和3D集成,如硅衬底和硅通孔(TSV),对于高效的HBM接口设计至关重要。与台积电(TSMC)等封装专家的合作可以帮助利益相关者利用尖端互连解决方案。

- 优化电源传输和热管理:随着HBM堆叠在密度和速度上的增长,电源传输和散热变得愈加困难。利益相关者应投资于先进的电源管理IC和创新的冷却解决方案,与CoolIT系统公司等合作提高热管理能力。

- 促进生态系统合作:参与行业协会和标准组织,如OIF(光互连论坛),可以帮助利益相关者了解接口创新和互操作性要求。

通过实施这些战略建议,利益相关者可以确保他们为AI加速器设计的HBM接口保持强大、可扩展和面向未来,支持下一代AI工作负载。